Estadística Aplicada

Principales Conceptos Teóricos y

Problemas Resueltos

Aplicaciones en Python

Giuliodori, David Augusto

ISBN 978-987-88-5778-7

Notaciones y Acrónimos

Parámetros y Estimadores

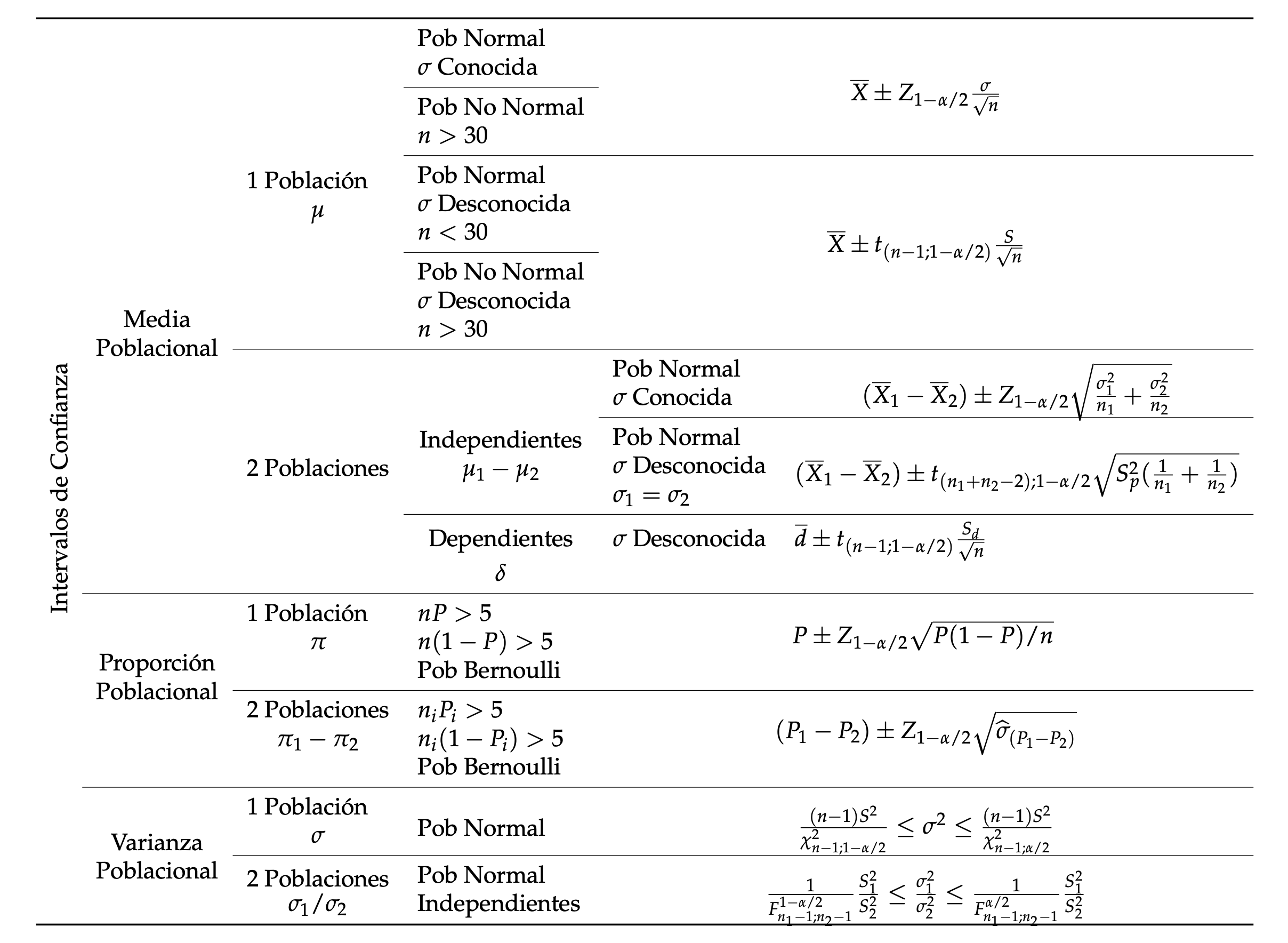

La siguiente tabla resume la simbología para los parámetros poblacionales y sus correspondientes estimadores muestrales.

| Concepto | Parámetro (Población) | Estimador (Muestra) |

|---|---|---|

| Media | \(\mu\) | \(\overline{X}\) |

| Varianza | \(\sigma^{2}\) | \(S^{2}\) |

| Covarianza entre \(X\) e \(Y\) | COV(X,Y) | Cov(X,Y) |

| Proporción | \(\pi\) | \(P\) |

| Diferencia de medias | \(\delta\) | \(d\) |

| Coeficiente de correlación | \(\rho\) | \(r\) |

| Término de error/Residuos | \(\epsilon\) | \(e\) |

| Coeficientes de Regresión Lineal | \(\beta_{i}\) | \(b_{i}\) |

Símbolos Matemáticos

\(\in\) Pertenece

\(\sim\) Se distribuye

\(\Rightarrow\) Implica

\(\mathbb{R}\) Conjunto de números reales

\(\vee\) Unión

\(E(.)\) Operador esperanza

\(V(.)\) Operador varianza

Int(.) Parte entera de un número

\(f^{o}\) Frecuencias Observadas

\(f^{e}\) Frecuencias Esperadas

Nomenclatura General

- Variable aleatoria: Letras latinas en mayúscula (ej: \(X\)).

- Observación muestral: Letras latinas en minúscula (ej: \(x_{i}\) es la i-ésima observación).

- Unidad de medida: Corchetes (ej: \([X]\) es la unidad de la variable \(X\)).

Acrónimos

- ANOVA: Analysis of Variance (Análisis de la Varianza)

- CMD: Cuadrado Medio Dentro de los grupos

- CME: Cuadrado Medio Entre grupos

- CMT: Cuadrado Medio Total

- CO: Curva Característica de Operación

- DW: Estadístico de Durbin-Watson

- EMV: Estimador por Máxima Verosimilitud

- MAS: Muestreo Aleatorio Simple

- MCO: Mínimos Cuadrados Ordinarios

- ME: Muestreo Estratificado

- SCD: Suma de los Cuadrados Dentro de los grupos

- SCE: Suma de los Cuadrados Entre grupos

- SCT: Suma de los Cuadrados Totales

- TAVN: Teorema de Adición de Variables Normales

- TCL: Teorema Central del Límite

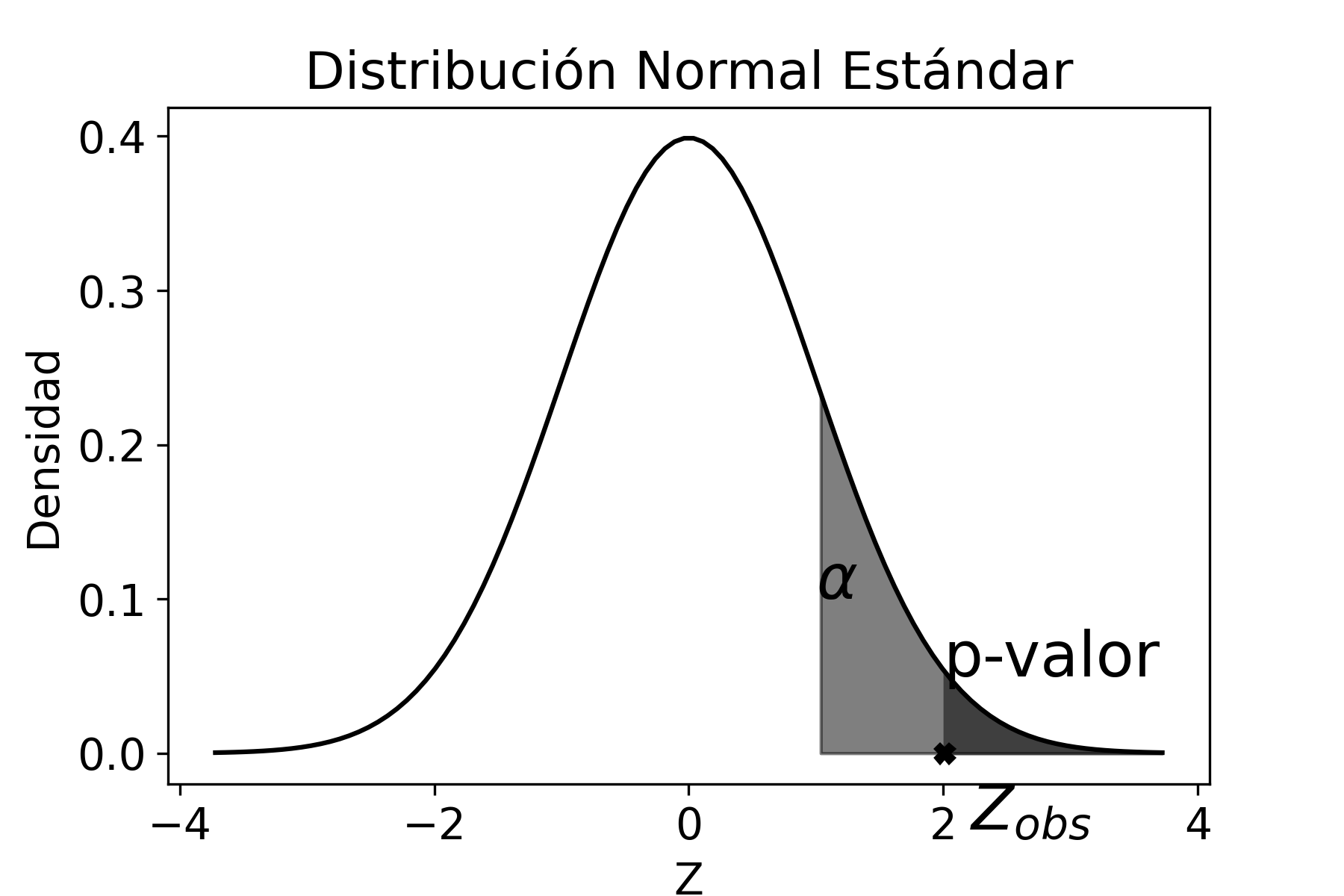

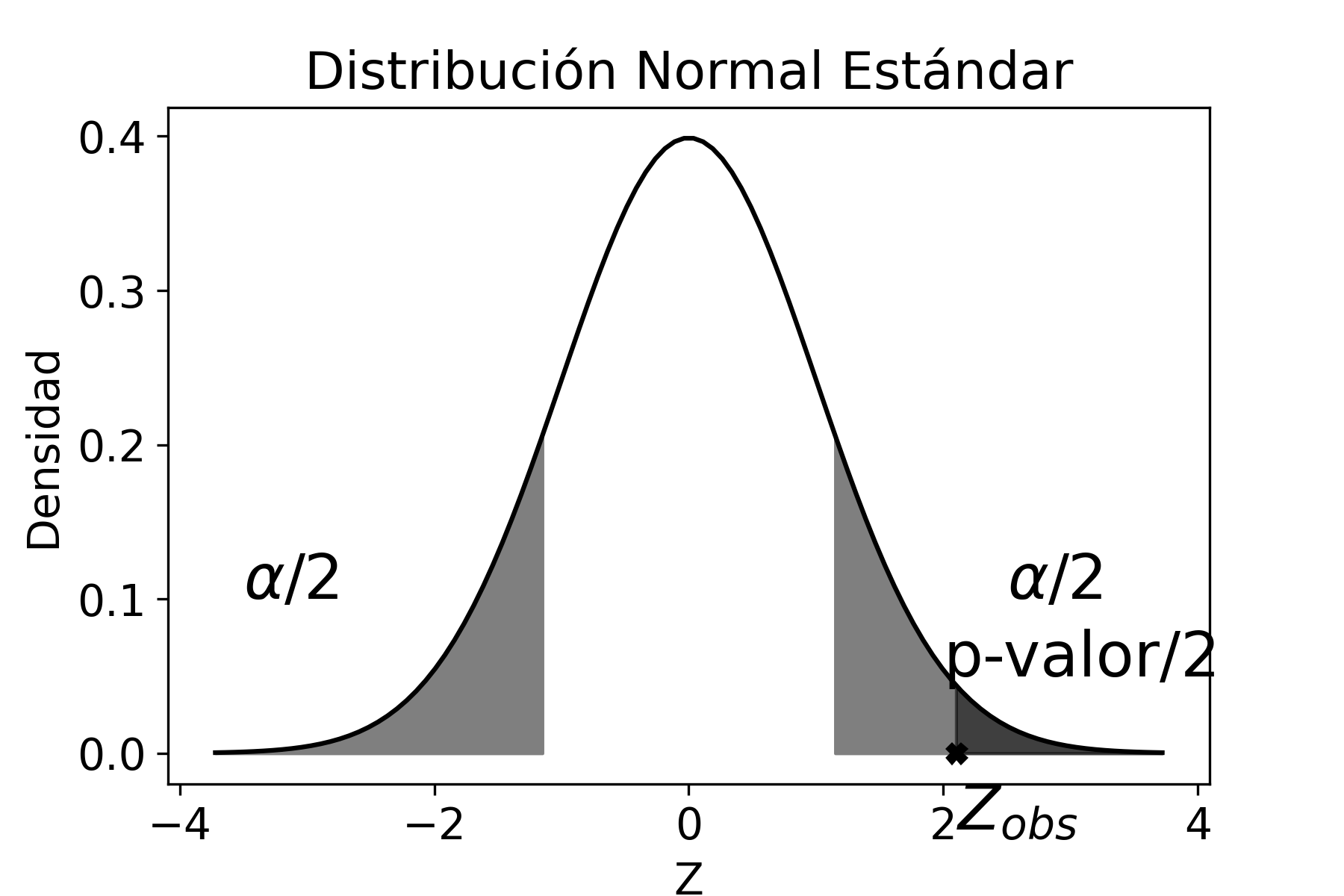

- ZR: Zona de Rechazo

Introducción

En estadística inferencial desempeñan un rol fundamental las distribuciones de probabilidad y el Teorema Central del Límite, que están estrechamente ligados a los conceptos de muestra, parámetro, estadístico y estimador, cuya definición rigurosa se introduce en la parte pertinente del libro, donde son abordados. A continuación incluimos una noción de cada uno de esos cuatro conceptos, a fin de facilitar la correcta comprensión de los temas en los que es necesario utilizarlos antes de ser debidamente definidos.

Muestra aleatoria simple es aquella que surge de utilizar un procedimiento de selección en el que ningún elemento de la población tiene más posibilidad que otro de ser elegido.

Parámetro es una medida (de posición, variabilidad, asimetría, etc) calculada con los elementos de la población.

Estadístico es una medida (de posición, variabilidad, asimetría, etc) calculada con los elementos de la muestra.

Estimador es un estadístico con una forma funcional particular que se usa para estimar un parámetro de la población, el cual suele ser desconocido. Para cada parámetro poblacional se puede construir un estimador, y pueden existir varios estimadores diferentes para el mismo parámetro.

En el primer capítulo abordaremos el tratamiento de algunas de las distribuciones más importantes del muestreo. Lo iniciaremos con la consideración de un teorema que nos permitirá plantear la distribución del estadístico que más se suele utilizar, esto es, la media muestral (o, en su caso, la proporción muestral). Ese teorema se denomina Teorema Central del Límite (TCL).

Teorema Central del Límite

Consideremos una suma de \(k\) variables aleatorias estadísticamente independientes que provienen de diferentes poblaciones, con distribuciones cualesquiera. Supongamos que dichas variables las representamos por:

\[\begin{aligned} X_{1},X_{2},\cdots ,X_{k} \nonumber \end{aligned}\] a sus medias o valores esperados por:

\[\begin{aligned} \mu_{1},\mu_{2},\cdots ,\mu_{k} \nonumber \end{aligned}\] y a sus correspondientes varianzas mediante

\[\begin{aligned} \sigma_{1}^{2},\sigma_{2}^{2},\cdots ,\sigma_{k}^{2} \nonumber \end{aligned}\]

Entonces, el Teorema Central del Límite expresa que la suma de esas \(n\) variables independientes provenientes de poblaciones con distribuciones cualesquiera tiende a distribuirse normalmente, a medida que \(k\) crece, con media igual a la suma de las medias y varianza igual a la suma de las varianzas. Es decir,

\[\begin{aligned} \sum_{i=1}^{k} X_{i} \sim N(\sum_{i}^{k} \mu_{i},\sum_{i}^{k} \sigma_{i}^{2}) \end{aligned}\]

El TCL justifica que se emplee la distribución normal para realizar inferencias estadísticas y también para llevar a cabo contrastes de hipótesis, todo ello sin necesidad de conocer, de antemano, el proceso que genera los datos.

Aplicaciones del Teorema Central del Límite

Media Muestral

Sean \(X_{1},X_{2} \cdots X_{n}\) variables aleatorias, idénticas e independientemente distribuidas, proveniente de una única población de variable \(X\), con media \(\mu\) y varianza \(\sigma^{2}\). Entonces, aplicando el TCL se cumple, cuando \(n\) es grande, que:

\[\begin{aligned} \overline{X} \sim N(\mu,\sigma^{2}/n) \end{aligned}\]

Lo que es equivalente a:

\[\begin{aligned} \frac{\overline{X}-\mu}{\sigma/\sqrt{n}} \sim N(0,1) \end{aligned}\]

Esto se debe a que la media muestral \(\overline{X}\) es el resultado de sumar las \(n\) variables divididas, cada una de ellas, por la constante \(n\). Esta suma de variables se distribuye normal con parámetros \(\mu\) y \(\frac{\sigma^{2}}{n}\), tal como se puede apreciar:

\[\begin{aligned} \overline{X}=\frac{\sum_{i=1}^{n}X_{i}}{n}=\frac{X_{1}}{n}+\frac{X_{2}}{n}+\cdots+\frac{X_{n}}{n} \end{aligned}\] por lo tanto \[\begin{aligned} E(\overline{X})\!=\; & E(\frac{X_{1}}{n}+\frac{X_{2}}{n}+\cdots+\frac{X_{n}}{n}) \nonumber \\ \!=\; & \frac{1}{n}(E(X_{1})+E(X_{2})+\cdots+E(X_{n}))=\frac{1}{n}n\mu=\mu \end{aligned}\] y para la varianza \[\begin{aligned} V(\overline{X})\!=\; & V\Big(\frac{\sum_{i=1}^{n}X_{i}}{n}\Big) \nonumber \\ \!=\; & \frac{1}{n^{2}}V\Big(\sum_{i=1}^{n}X_{i}\Big) \nonumber \\ \!=\; & \frac{1}{n^{2}}(V(X_{1})+V(X_{2})+\cdots+V(X_{n})=\frac{1}{n^{2}}n\sigma^{2}=\frac{\sigma^{2}}{n} \end{aligned}\]

En el caso de variables provenientes de distribuciones normales, la media muestral se distribuye normalmente, cualquiera sea el tamaño de muestra \(n\), por el Teorema de Adición de Variables Normales (TAVN). En efecto, si se tienen \(X_{1}, \cdots X_{n}\) variables aleatorias normales, idéntica e independientemente distribuidas, con medias \(\mu_{i}\) y varianzas \(\sigma_{i}^{2}\), se cumple que \(\overline{X}\) es siempre normal, ya sea por aplicación del TCL (y también por el TAVN) si \(n\) es grande, o por el TAVN si \(n\) es pequeño.

Proporción Muestral

Sean \(X_{1}, \cdots X_{n}\) variables aleatorias, idéntica e independientemente distribuidas provenientes de una distribución dicotómica (Bernoulli). El estadístico proporción muestral se define como:

\[\begin{aligned} P=\frac{\sum_{i}^{n}X_{i}}{n} \end{aligned}\] es decir que \(P\) no es más que \(\overline{X}\) cuando la distribución de cada una de las \(n\) variables es Bernoulli. Recordemos que para la distrbución de Bernoulli \(E(X)=\pi\) y que \(V(X)=\pi(1-\pi)\). Entonces, se cumple, por el TCL, que cuando \(n\) es lo suficientemente grande:

\[\begin{aligned} P \sim N(\pi,\pi(1-\pi)/n) \end{aligned}\]

Distribuciones derivadas de la Normal

Uno de los objetivos de la Estadística es conocer información relevante de los parámetros poblacionales de una o más distribuciones: la media (\(\mu\)), la varianza (\(\sigma^{2}\)) o la proporción (\(\pi\)). En la práctica escasas veces conoceremos estos valores, por lo que es necesario extraer una muestra aleatoria simple de la población y calcular el valor del estimador, por ejemplo, la media muestral (\(\overline{X}\)), la varianza muestral (\(S^{2}\)) o la proporción muestral (\(P\)), que permita hacer inferencia acerca del respectivo parámetro poblacional. El valor del estimador es aleatorio porque depende de los elementos que se presenten en la muestra seleccionada y, por lo tanto, tiene una distribución de probabilidad asociada. El estudio de estas distribuciones es necesario para entender el proceso de inferencia estadística que será discutido posteriormente. A continuación veremos tres de esas distribuciones muestrales.

Distribución Chi\(^{2}\)

Supongamos que hay \(n\) variables aleatorias independientes \(Z_{i}\), todas con distribución \(N(0,1)\), entonces se define la variable aleatoria \(\chi^{2}\) (denominada chi-cuadrado) como:

\[\begin{aligned} \chi^{2}_{n}\!=\; & \sum^{n}_{i=1}{Z^{2}_{i}} \nonumber \\ \!=\; & \sum^{_n}_{i=1}\bigg(\frac{X_{i}-\mu}{\sigma}\bigg)^{2} \end{aligned}\] donde \(n\) representa los grados de libertad1, es decir la cantidad de valores de \(X\) que son independientes.

Dado que generalmente no se conoce \(\mu\), entonces en la estandarización se pierde un grado de libertad al trabajar con \(\overline{X}\) en lugar de \(\mu\), por lo tanto:

\[\begin{aligned} \chi^{2}_{n-1}\!=\; & \sum^{n}_{i=1}\bigg(\frac{X_{i}-\overline{x}}{\sigma}\bigg)^{2} \end{aligned}\]

Sabiendo que:

\[\begin{aligned} S^{2}=\sum^{n}_{i=1} \frac{(X_{i}-\overline{X})^{2}}{n-1} \end{aligned}\] podemos escribir el estadístico \(\chi^{2}\) como

\[\label{estadistico_chi} {\chi^{2}_{n-1}=\frac{(n-1)S^{2}}{\sigma^{2}}}\]

\(\chi^{2}\) tiene una distribución de probabilidad definida positiva, asimétrica que tiende a ser simétrica a medida que aumentan los grados de libertad.

Por otra parte, haciendo uso de la función generadora de momentos de esta distribución \(\chi^{2}\):

\[\begin{aligned} M_{X}(t)=(1-2t)^{-r/2} \quad \forall \quad t<1/2 \end{aligned}\] donde \(r\) representa los grados de libertad (\(n-1\)), podemos calcular los momentos derivando sucesivamente esta función y evaluando dicha derivada en \(t=0\). Con la derivada primera tenemos:

\[\begin{aligned} E(X^{k})=\frac{d^{k}M_{X}(t)}{dt^{k}}\bigg |_{t=0} \end{aligned}\]

Para obtener el primer momento esperanza tomamos \(k=1\):

\[\begin{aligned} E(X)\!=\; & \frac{d M_{X}(t)}{dt}\bigg |_{t=0} \nonumber \\ \!=\; & r(1-2t)^{-r/2-1}\bigg |_{t=0}=r \end{aligned}\]

Para el segundo momento tomamos \(k=2\):

\[\begin{aligned} E(X^{2})\!=\; & \frac{d^{2}M_{X}(t)}{dt^{2}}\bigg |_{t=0} \nonumber \\ \!=\; & (-2) (-r/2-1) r(1-2t)^{-r/2-2}\bigg |_{t=0}=r^{2}+2r \end{aligned}\] y así sucesivamente para los otros momentos.

La varianza es:

\[\begin{aligned} V(X)\!=\; & E(X^{2})-E(X)^{2} \nonumber \\ \!=\; & r^{2}+2r - r^{2}=2r \end{aligned}\]

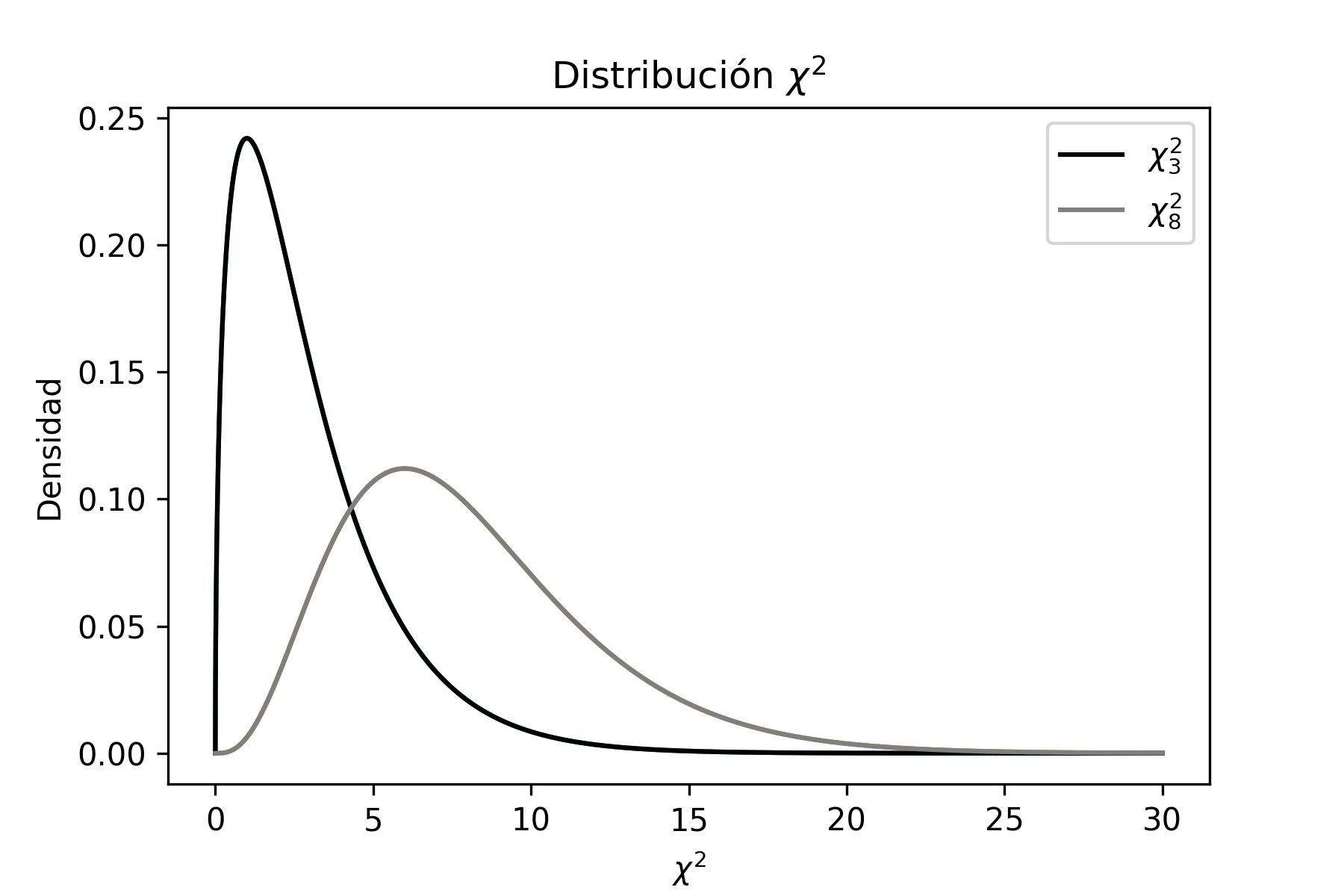

Problema Resuelto 1.1. Graficar en Python las distribuciones \(\chi^{2}\) de 3 y 8 grados de libertad y analizar las diferencias que hay entre ellas.

Solución

Lo primero que debemos hacer es importar las librerías de Python necesarias para poder hacer los gráficos2. Posteriormente, asignamos los grados de libertad de cada una de las distribuciones en las distintas variables definidas en el código, en este caso \(df\) y \(df2\).

import numpy as np

from scipy import stats

import matplotlib.pyplot as plt

from scipy.stats import norm

# Graficando Chi

df = 3 # grados de libertad de la primera funcion

df2 = 8 # grados de libertad de la segunda funcion

chi = stats.chi2(df)

chi2 = stats.chi2(df2)

x = np.linspace(chi2.ppf(0.01),

chi2.ppf(0.99), 100)

x = np.arange(0., 30., 0.001)

# Funcion de Densidad

fp = chi.pdf(x)

fp2 = chi2.pdf(x)

plt.plot(x, fp)

plt.plot(x, fp2)

plt.plot(x, fp,label=r'$\chi^{2}_{3}$',color='tab:orange')

plt.plot(x, fp2,label=r'$\chi^{2}_{8}$', color='tab:blue')

plt.title(r'Distribucion $\chi^{2}$')

plt.ylabel('Densidad')

plt.xlabel('r'$\chi^{2}$')

plt.legend()

plt.show()

plt.savefig('chi2.png')El gráfico que se obtiene (se guarda como archivo de imagen con extensión png), viene dado por:

donde se observa que, a medida que los grados de libertad aumentan, la distribución se vuelve más simétrica.

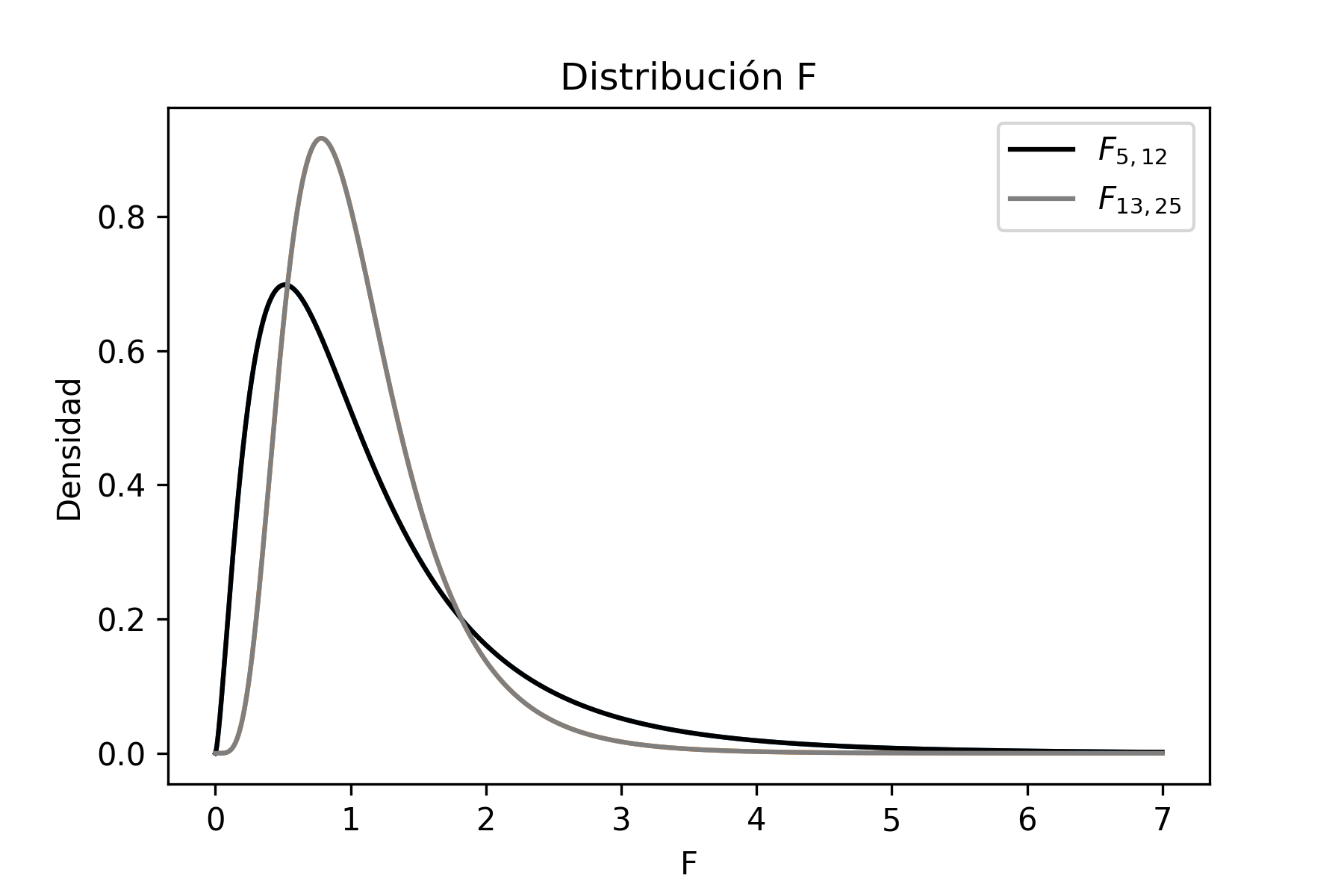

Distribución F

Sean \(U\) y \(V\) dos variables aleatorias que se distribuyen \(\chi^{2}\) con \(n_{1}-1\) y \(n_{2}-1\) grados de libertad respectivamente, entonces:

\[\begin{aligned} U &\sim & \chi^{2}_{n_{1}-1} \nonumber \\ V &\sim & \chi^{2}_{n_{2}-1} \end{aligned}\]

Se define la distribución \(F\) como:

\[\begin{aligned} F_{n_{1}-1,n_{2}-1}=\frac{\frac{U}{n_{1}-1}}{\frac{V}{n_{2}-1}}=\frac{ \frac{\frac{(n_{1}-1)S_{1}^{2}}{\sigma_{1}^{2}}}{n_{1}-1}} {\frac{\frac{(n_{2}-1)S_{2}^{2}}{\sigma_{2}^{2}}}{n_{2}-1}} \nonumber \end{aligned}\] \[\label{estadistico_f1} {F_{n_{1}-1,n_{2}-1}=\frac{S_{1}^{2}}{S_{2}^{2}}\frac{\sigma_{2}^{2}}{\sigma_{1}^{2}}}\]

La distribución \(F\) es una distribución definida positiva y asimétrica que, a medida que aumentan los grados de libertad del numerador y del denominador, tiende a perder la asimetría, es decir tiende a ser simétrica.

El código de Python que genera el gráfico anterior es el que sigue. Cabe destacar que las librerías necesarias para este script son las mismas que fueron utilizadas anteriormente.

# Graficando F

dfn = 5 # grados de libertad del numerador de la primera funcion

dfd = 12 # grados de libertad del denominador de la primera funcion

dfn2 = 13 # grados de libertad del numerador de la segunda funcion

dfd2 = 25 # grados de libertad del denominador de la segunda funcion

f = stats.f(dfn,dfd)

f2 = stats.f(dfn2,dfd2)

x = np.linspace(f.ppf(0.01),

f.ppf(0.99), 100)

x = np.arange(0, 7., 0.001)

#Funcion de Densidad

fp = f.pdf(x)

fp2 = f2.pdf(x)

plt.plot(x, fp)

plt.plot(x, fp2)

plt.title('Distribucion F')

plt.ylabel('Densidad')

plt.xlabel('F')

plt.plot(x, fp,label=r'$F_{5,12}$', color='black')

plt.plot(x, fp2,label=r'$F_{13,25}$',color='tab:gray')

plt.legend()

plt.show()Una transformación de la distribución \(F\) que suele ser de gran utilidad es la siguiente:

\[\begin{aligned} F^{\alpha}_{n_{1},n_{2}}=\frac{1}{F^{1-\alpha}_{n_{2},n_{1}}} \end{aligned}\]

Si se calcula la esperanza y la varianza para la distribución \(F\), se obtienen los siguientes resultados:

\[\begin{aligned} E(F)\!=\; & \frac{n_{2}-1}{(n_{2}-1)-2} \nonumber \\ V(F)\!=\; & \frac{2(n_{2}-1)^{2}\left[(n_{1}-1)+(n_{2}-1)-2\right]}{(n_{1}-1)[(n_{2}-1)-2]^{2}[(n_{2}-1)-4]} \end{aligned}\]

Distribución t-Student

Sean \(Z\) y \(U\) dos variables aleatorias donde:

\[\begin{aligned} Z&\sim & N(0,1) \nonumber \\ U &\sim & \chi^{2}_{n-1} \end{aligned}\]

Entonces la distribución \(t\) con \(n-1\) grados de libertad, se define como:

\[\begin{aligned} \label{est_t0} t_{n-1}=\frac{Z}{\sqrt{\frac{U}{n-1}}} \end{aligned}\]

Por el TCL sabemos:

\[\begin{aligned} Z\!=\; & \frac{\overline{X}-\mu}{\sigma / \sqrt{n}} \end{aligned}\]

Además, tenemos que:

\[\begin{aligned} U\!=\; & \frac{(n-1)S^{2}}{\sigma^{2}} \end{aligned}\]

Entonces, reemplazando en [est_t0]:

\[\begin{aligned} t_{n-1}\!=\; & \frac{\frac{\overline{X}-\mu}{\sigma/\sqrt{n}}}{\sqrt{\frac{(n-1)S^{2}/\sigma^{2}}{n-1}}} \nonumber \end{aligned}\] \[\label{estadistico_t} {t_{n-1} =\frac{\overline{X}-\mu}{S/\sqrt{n}}}\]

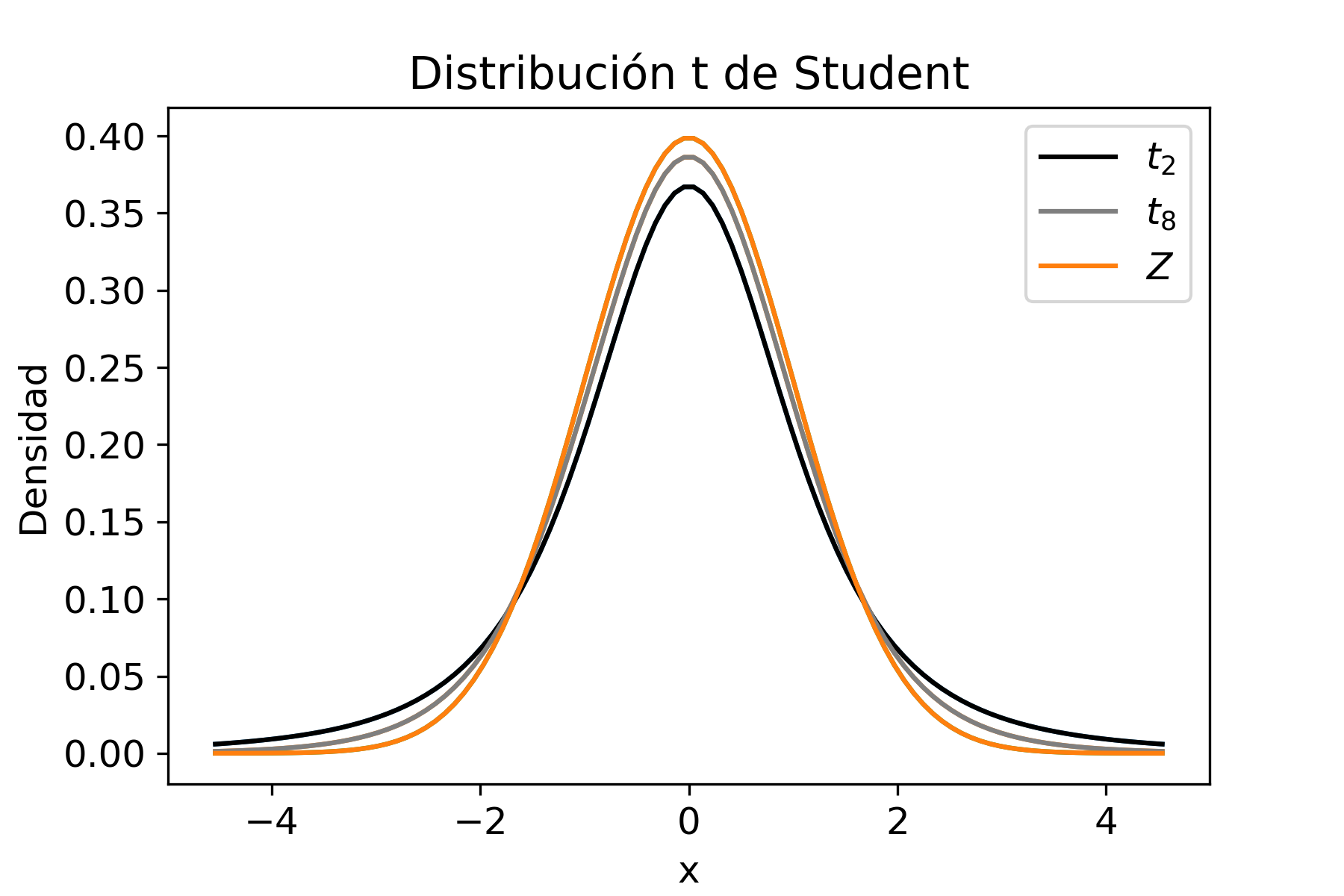

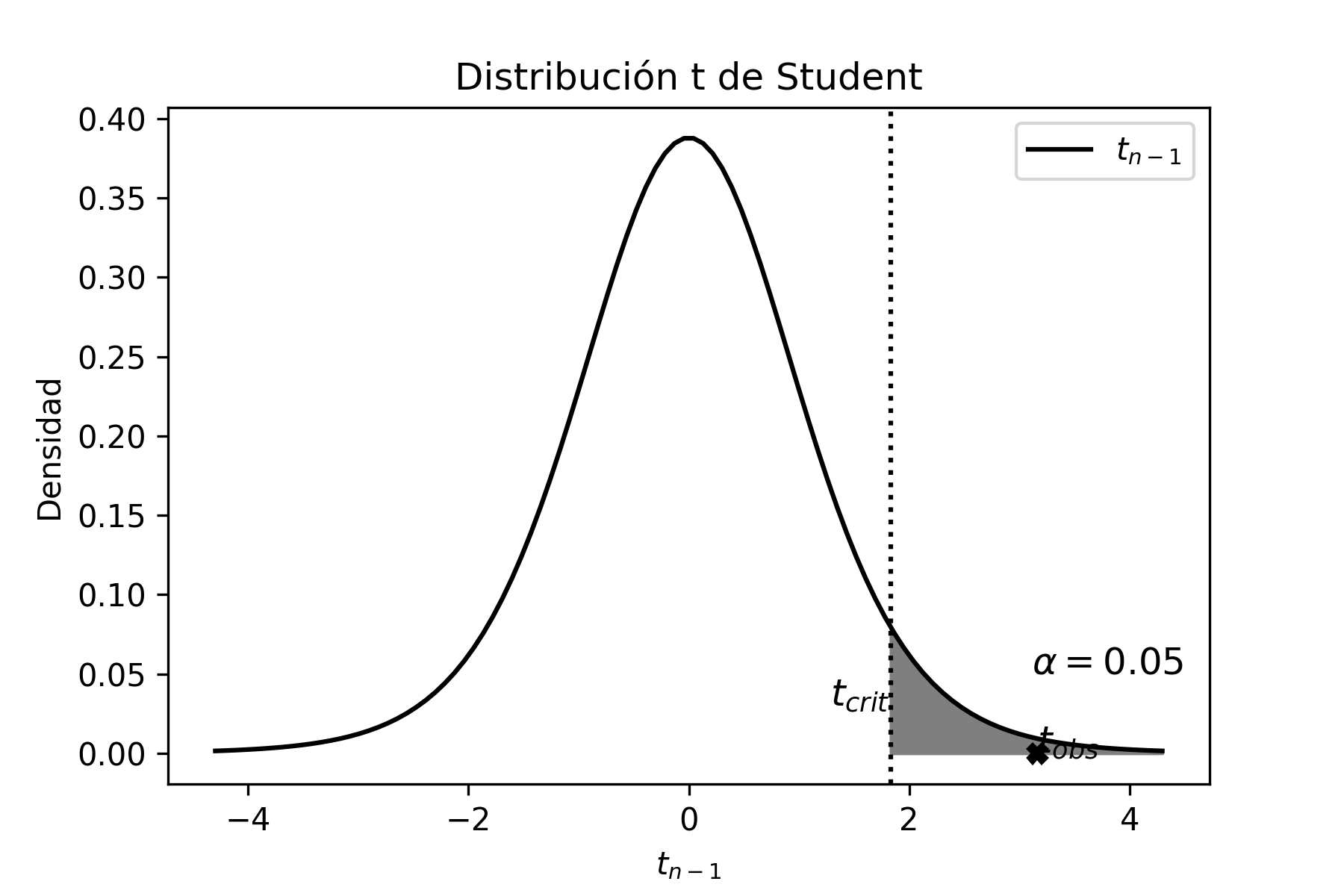

Esta distribución es simétrica, con media cero y con menor kurtosis que la normal. Cuando la cantidad de grados de libertad tiende a infinito, la distribución \(t\) tiende a \(Z\), es decir a la normal estándar. O sea

\[\begin{aligned} \lim_{n\rightarrow \infty}t_{n-1}=Z \end{aligned}\]

La esperanza y la varianza de la distribución \(t\)-Student son:

\[\begin{aligned} E(t)\!=\; & 0 \nonumber \\ V(t)\!=\; & \frac{n-1}{(n-1)-2} \end{aligned}\]

La forma gráfica de la distribución t-Student se muestra en la siguiente figura junto a la distribución normal estándar.

El script en Python para generar el gráfico anterior, que compara la distribución \(t\) con la normal estándar es presentado a continuación:

import numpy as np

from scipy import stats

import matplotlib.pyplot as plt

from scipy.stats import norm

import scipy.stats as st

mu, sigma = 0, 1 # media y desvio estandar

normal = stats.norm(mu, sigma)

# Graficando t de Student

df = 3 # grados de libertad de la primera distribucion

df2 = 8 # grados de libertad de la segunda distribucion

t = stats.t(df)

t2 = stats.t(df2)

x = np.linspace(t.ppf(0.01),

t.ppf(0.99), 100)

fp = t.pdf(x)

fp2 = t2.pdf(x)

fp3 = normal.pdf(x)

plt.rcParams["font.size"] = "14"

plt.plot(x, fp)

plt.plot(x, fp2)

plt.plot(x, fp3)

plt.plot(x, fp,label=r'$t_{2}$',color='black')

plt.plot(x, fp2,label=r'$t_{8}$', color='tab:gray')

plt.plot(x, fp3,label=r'$Z$', color='tab:orange')

plt.title('Distribucion t de Student')

plt.ylabel('Densidad')

plt.xlabel('x')

plt.legend()

plt.show()Estimadores y sus Propiedades

Definición 1.1. Un estimador \(\hat{\theta}\) es una medida, con una forma funcional particular, que se usa para estimar el parámetro de la población \(\theta\).

Dado que, para cada parámetro poblacional, pueden existir más de un estimador, debemos poder efectuar comparaciones entre ellos para identificar el mejor. Es por ello que existen criterios para evaluar la calidad de los estimadores, que nos indican cuál es el adecuado para el parámetro considerado. Los principales criterios o propiedades son los siguientes:

Insesgado: Se denomina sesgo de un estimador a la diferencia entre la esperanza del estimador y el verdadero valor del parámetro a estimar. Es deseable que un estimador sea insesgado o centrado, es decir, que su sesgo sea nulo por ser su esperanza igual al parámetro que se desea estimar. Matemáticamente:

\[\begin{aligned} E(\hat{\theta})=\theta \end{aligned}\]

Eficiencia: Diremos que un estimador es más eficiente o más preciso que otro estimador, si la varianza del primero es menor que la del segundo3. La eficiencia nos indica el tamaño del error estándar del estadístico. Supongamos que tenemos dos estimadores \(\hat{\theta}_{1}\) y \(\hat{\theta}_{2}\) del parámetro poblacional \(\theta\), entonces el estimador \(\hat{\theta}_{1}\) será más eficiente que \(\hat{\theta}_{2}\) si se cumple que:

\[\begin{aligned} V(\hat{\theta}_{1})<V(\hat{\theta}_{2}) \end{aligned}\]

Consistencia: Si no es posible emplear estimadores de mínima varianza, el requisito mínimo deseable para un estimador es que, a medida que el tamaño de la muestra crece, el valor del estimador tienda al valor del parámetro, propiedad que se denomina consistencia. Es decir:

\[\begin{aligned} E(\hat{\theta}) \rightarrow \theta \quad \text{cuando} \quad n \rightarrow \infty \end{aligned}\]

Robustez: Un estimador \(\hat{\theta}\) de un cierto parámetro de la población \(\theta\) se dice que es robusto si la vulneración de los supuestos de partida en los que se basa la estimación (generalmente, atribuir a la población un determinado tipo de función de distribución que, en realidad, no es la correcta), no altera de manera significativa los resultados que el estimador proporciona.

Suficiencia: Se dice que un estimador es suficiente cuando resume toda la información relevante contenida en la muestra, de forma que ningún otro estimador pueda proporcionar información adicional sobre el parámetro desconocido de la población.

Problema Resuelto 1.2. Sean \(X_{1}\), \(X_{2}\) y \(X_{3}\) los valores de gasto familiar en supermercado de una muestra de tamaño 3, tomada de una localidad con gasto en supermercado promedio \(\mu\) y varianza \(\sigma^{2}\). Si definimos los siguientes estimadores para la media poblacional:

\(\overline{X}=k/3X_{1}+k/3X_{2}+k/3X_{3}\)

\(\overline{X}=k/4X_{1}+2k/4X_{2}+k/4X_{3}+1\)

\(\overline{X}=k/5X_{1}+2k/5X_{2}+2k/5X_{3}+2\)

donde \(k\in \mathrm{R}>0\).

Indique cuál de los estimadores es más eficiente y tiene menor sesgo.

Solución

Calculemos primero la esperanza para el estimador I).

\[\begin{aligned} E(\overline{X})\!=\; & E(k/3\cdot X_{1}+k/3\cdot X_{2}+k/3\cdot X_{3}) \nonumber \\ \!=\; & E(k/3\cdot X_{1})+E(k/3\cdot X_{2})+E(k/3\cdot X_{3}) \nonumber \\ \!=\; & k/3E(X_{1})+k/3E(X_{2})+k/3E(X_{3}) \nonumber \\ \!=\; & k/3\mu+k/3\mu+k/3\mu \nonumber \\ \!=\; & k \cdot \mu \end{aligned}\]

Operando de forma similar, se llega a la esperanza de los estimadores II) y III):

\[\begin{aligned} E(\overline{X})\!=\; & E(k/4\cdot X_{1}+2k/4\cdot X_{2}+k/4\cdot X_{3}+1) \nonumber \\ \!=\; & k \cdot \mu+1 \nonumber \\ E(\overline{X})\!=\; & E(k/5\cdot X_{1}+2k/5\cdot X_{2}+2k/5\cdot X_{3}+2) \nonumber \\ \!=\; & k \cdot \mu+2 \nonumber \end{aligned}\]

Los tres estimadores son sesgados, pero el que tiene el menor sesgo es el I) dado que estamos hablando de gasto en supermercado y la esperanza de esa variable es positiva y \(k\in \mathrm{R}>0\).

Ahora queda por ver cuál de los estimadores es más eficiente. Calculemos la varianza del primer caso.

\[\begin{aligned} V(\overline{X})\!=\; & V(k/3\cdot X_{1}+k/3\cdot X_{2}+k/3\cdot X_{3}) \nonumber \\ \!=\; & V(k/3\cdot X_{1})+V(k/3\cdot X_{2})+V(k/3\cdot X_{3}) \nonumber \\ \!=\; & (k/3)^{2}V(X_{1})+(k/3)^{2}V(X_{2})+(k/3)^{2}V(X_{3}) \nonumber \\ \!=\; & k^{2}/9\sigma^{2}+k^{2}/9\sigma^{2}+k^{2}/9\sigma^{2}\nonumber \\ \!=\; & k^{2}/3\sigma^{2} \end{aligned}\]

Operando para los otros dos estimadores, teniendo en cuenta que \(V(c)=0\) siendo \(c\) una constante, se obtienen los siguientes resultados:

\(V(\overline{X})=6k^{2}/16 \cdot \sigma^{2}\)

\(V(\overline{X})=9k^{2}/25 \cdot \sigma^{2}\)

Como conclusión, el estimador más eficiente es el I), pues tiene la varianza más pequeña.

Estimador de la varianza poblacional

Supongamos que construimos un estimador \(\widehat{\theta}\) de la varianza poblacional, como la suma de los desvíos respecto a la media muestral elevados al cuadrado, divida por el tamaño de la muestra \(n\). En otras palabras:

\[\begin{aligned} \widehat{\theta}\!=\; & \frac{\sum_{i=1}^{n}{(X_{i}-\overline{X})^{2}}} {n} \end{aligned}\]

Operando matemáticamente sobre el estimador \(\theta\), tenemos:

\[\begin{aligned} \widehat{\theta}\!=\; & \frac{\sum_{i=1}^{n}{(X_{i}-\overline{X})^{2}}} {n} \\ \!=\; & \frac{\sum_{i=1}^{n}{(X_{i}^{2}-2X_{i}\overline{X}+\overline{X}^{2}})} {n} \nonumber \\ \!=\; & \frac{\sum_{i=1}^{n}{X_{i}^{2}}-2\sum_{i=1}^{n}{X_{i}\overline{X}}+\sum_{i=1}^{n}{\overline{X}^{2}}} {n} \nonumber \\ \!=\; & \frac{\sum_{i=1}^{n}{X_{i}^{2}}-2n\overline{X}\overline{X}+n\overline{X}^{2}} {n} \nonumber \\ \!=\; & \frac{\sum_{i=1}^{n}{X_{i}^{2}}-n\overline{X}^{2}} {n} \end{aligned}\]

Tomando esperanza:

\[\begin{aligned} \label{s2} E(\widehat{\theta})\!=\; & E \Big(\frac{\sum_{i=1}^{n}{X_{i}^{2}}-n\overline{X}^{2}} {n}\Big) \nonumber \\ \!=\; & \frac{\sum_{i=1}^{n}{E(X_{i}^{2})}}{n}-\frac{nE(\overline{X}^{2})}{n} \nonumber \\ \!=\; & \frac{\sum_{i=1}^{n}{E(X_{i}^{2})}}{n}-E(\overline{X}^{2}) \end{aligned}\]

Sabiendo que:

\[\begin{aligned} E(\overline{X})\!=\; & \mu \nonumber \\ V(\overline{X})\!=\; & \sigma^{2}/n \nonumber \\ E(X_{i})\!=\; & \mu \nonumber \\ V(X_{i})\!=\; & \sigma^{2} \end{aligned}\] y que:

\[\begin{aligned} \label{var_esp} V(X)\!=\; & E(X^{2})-(E(X))^{2} \end{aligned}\] por lo que:

\[\begin{aligned} \label{res1} E(X_{i}^{2})\!=\; & V(X_{i})+(E(X_{i}))^{2} \nonumber \\ \!=\; & \sigma^{2}+\mu^{2} \end{aligned}\]

Por otro lado, aplicando [var_esp] a la \(\overline{X}\), y despejando \(E(\overline{X}^{2})\):

\[\begin{aligned} \label{res2} E(\overline{X}^{2})\!=\; & V(\overline{X})+(E(\overline{X}))^{2} \nonumber \\ \!=\; & \sigma^{2}/n+\mu^{2} \end{aligned}\] y llevando los resultados de [res1] y [res2] a la ecuación ([s2]), tenemos que:

\[\begin{aligned} E(\widehat{\theta})\!=\; & \frac{\sum_{i=1}^{n}{E(X_{i}^{2})}}{n}-E(\overline{X}^{2}) \nonumber \\ \!=\; & \frac{\sum_{i=1}^{n}{(\sigma^{2}+\mu^{2})}}{n}-(\sigma^{2}/n+\mu^{2}) \nonumber \\ \!=\; & \sigma^{2}+\mu^{2}-\sigma^{2}/n-\mu^{2} \nonumber \\ \!=\; & \frac{n-1}{n} \sigma^{2} \end{aligned}\]

Así se llega a la conclusión que, para obtener un estimador insesgado de la varianza poblacional, hay que multiplicar al estimador \(\widehat{\theta}\) por \(n/(n-1)\), es decir:

\[\begin{aligned} \label{varianza_muestral_ec} \widehat{\theta} \cdot \frac{n}{n-1}\!=\; & \frac{\sum_{i=1}^{n}{(X_{i}-\overline{X})^{2}}} {n} \cdot \frac{n}{n-1} \nonumber \\ \!=\; & \frac{\sum_{i=1}^{n}{(X_{i}-\overline{X})^{2}}} {n-1} \nonumber \\ \!=\; & \frac{\sum_{i=1}^{n}{X^{2}_{i}}-n\overline{X}^{2}} {n-1} = S^{2} \end{aligned}\]

\(S^{2}\) es entonces, el estimador insesgado de la varianza poblacional.

Estimación por Máxima Versosimilitud

Supongamos que tenemos una muestra \(X_{1}, X_{2}, \cdots, X_{n}\) de \(n\) observaciones independientes e idénticamente distribuidas, extraídas en forma aleatoria de una distribución desconocida con función de densidad (o función de probabilidad) \(f_{0}(\cdot)\). Si se sabe que \(f_{0}\) pertenece a una familia de distribuciones conocidas, el método de máxima verosimilitud consiste en seleccionar como valor estimado del parámetro de la función \(f_{0}\), aquél que maximiza la probabilidad de una muestra (a posteriori de haberla extraído), con respecto a todos los valores posibles del parámetro. En otras palabras, maximiza la probabilidad de presentación conjunta de todas las observaciones de la muestra.

Problema Resuelto 1.3. Calcular los estimadores máximo verosímiles de los parámetros \(\mu\) y \(\sigma^{2}\) de la función de distribución normal.

Solución

La función de distribución individual de una variable normal es:

\[\begin{aligned} f(\mu,\sigma^{2},X_{i})=\frac{1}{\sqrt{2\pi \sigma^{2}}}e^{-\frac{1}{2}\frac{(X_{i}-\mu)^{2}}{\sigma^{2}}} \end{aligned}\]

Planteando la función de verosimilitud para una muestra aleatoria de tamaño \(n\)4, tenemos:

\[\begin{aligned} L(\mu,\sigma^{2},X_{i})\!=\; & f(X_{1},X_{2},...,X_{n},\mu,\sigma^{2}) \nonumber \\ \!=\; & \prod_{i=1}^{n}{f(X_{i},\mu,\sigma^{2})} \nonumber \\ \!=\; & \prod_{i=1}^{n}{\frac{1}{\sqrt{2\pi \sigma^{2}}}e^{-\frac{1}{2}\frac{(X_{i}-\mu)^{2}}{\sigma^{2}}}} \nonumber \\ \!=\; & \bigg(\frac{1}{\sqrt{2\pi \sigma^{2}}}\bigg)^{n}e^{-\frac{1}{2}\frac{\sum_{i=1}^{n}{(X_{i}-\mu)^{2}}}{\sigma^{2}}} \end{aligned}\]

Ahora tomamos logaritmo a la función de verosimilitud, ya que es una transformación monótona que simplifica los cálculos, y operamos teniendo en cuenta las propiedades del logaritmo:

\[\begin{aligned} \ln{L(\mu,\sigma^{2},X_{i})}\!=\; & \ln{\bigg(\bigg(\frac{1}{\sqrt{2\pi \sigma^{2}}}\bigg)^{n}e^{-\frac{1}{2}\frac{\sum_{i=1}^{n}{(X_{i}-\mu)^{2}}}{\sigma^{2}}}\bigg)} \nonumber \\ \!=\; & -\frac{n}{2 } \ln{(2\pi \sigma^{2})}-\frac{1}{2}\frac{\sum_{i=1}^{n}{(X_{i}-\mu)^{2}}}{\sigma^{2}} \end{aligned}\]

En esta función debemos hallar los valores de los parámetros que la maximizan. Para ello hay que plantear las condiciones de primer orden respecto a \(\mu\) y a \(\sigma^{2}\), es decir:

\[\begin{aligned} \frac{\partial \ln{L(\mu,\sigma^{2},X_{i})}}{\partial \mu}\!=\; & -\frac{1}{2}\frac{2}{\sigma^{2}}\sum_{i=1}^{n}{(X_{i}-\mu)}(-1) \nonumber \\ \frac{\partial \ln{L(\mu,\sigma^{2},X_{i})}}{\partial \sigma^{2}}\!=\; & -\frac{n}{2} \frac{2\pi}{2\pi \sigma^{2}}-\frac{1}{2} \sum_{i=1}^{n}{(X_{i}-\mu)^{2}} (\sigma^{2})^{-2} \end{aligned}\]

Igualando la primer condición de primer orden a cero y despejando \(\mu\) obtenemos:

\[\begin{aligned} \frac{1}{\widehat{\sigma}^{2}}\sum_{i=1}^{n}{(X_{i}-\overline{X})} \!=\; & 0 \nonumber \\ \sum_{i=1}^{n}{(X_{i}-\overline{X})}\!=\; & 0 \nonumber \\ \overline{X}\!=\; & \frac{\sum_{i=1}^{n}{X_{i}}}{n} \end{aligned}\]

Si se iguala a cero la segunda condición de primer orden y se despeja \(\widehat{\sigma}^{2}\), tenemos

\[\begin{aligned} -n+\frac{\sum_{i=1}^{n}{(X_{i}-\overline{X})^{2}}}{ \widehat{\sigma}^{2}}\!=\; & 0 \nonumber \\ \widehat{\sigma}^{2}\!=\; & \frac{\sum_{i=1}^{n}{(X_{i}- \overline{X})^{2}}}{ n} \end{aligned}\]

Como vemos, el estimador máximo verosímil de la varianza es un estimador sesgado ya que utiliza los desvíos respecto a la media muestral. Por eso es que debe ser corregido para que desaparezca el sesgo, dividiendo por \(n-1\) en lugar de por \(n\) (ver [varianza_muestral_ec]).

Problema Resuelto 1.4. Una empresa de emergencias cree que la cantidad de llamadas diarias de casos graves que ingresan al call center, sigue un modelo de Poisson. Contando con una muestra de 30 días en las que se produjeron 102 llamadas de emergencias graves al call center, se desea obtener la estimación máximo verosímil del promedio de llamadas graves, suponiendo un modelo de Poisson.

Solución

La distribución de Poisson viene dada por la siguiente función de cuantía:

\[\begin{aligned} f(X_{i},\lambda)=\frac{e^{-\lambda} \lambda^{X_{i}}}{X_{i}!} \end{aligned}\]

Calculemos la función de verosimilitud.

\[\begin{aligned} L(\lambda) \!=\; & f(X_{1},X_{2},...,X_{n},\lambda) \nonumber \\ \!=\; & \prod_{i=1}^{n}\frac{e^{-\lambda} \lambda^{X_{i}}}{X_{i}!} \nonumber \\ \!=\; & \frac{(e^{-\lambda})^{n} \lambda^{\sum_{i=1}^{n}X_{i}}}{\prod_{i=1}^{n}X_{i}!} \end{aligned}\]

Tomando logaritmo a la función \(L\)

\[\begin{aligned} \ln{L(\lambda)}\!=\; & \ln{\frac{(e^{-\lambda})^{n} \lambda^{\sum_{i=1}^{n}X_{i}}}{\prod_{i=1}^{n}X_{i}!}} \nonumber \\ \!=\; & \ln{(e^{-\lambda}})^{n}+\ln{\lambda^{\sum_{i=1}^{n}X_{i}}}-\ln{\prod_{i=1}^{n}X_{i}!} \nonumber \\ \!=\; & -\lambda n + \sum_{i=1}^{n}X_{i} \ln{\lambda} -\ln{\prod_{i=1}^{n}X_{i}!} \end{aligned}\]

Planteando la condición de primer orden

\[\begin{aligned} \frac{\partial \ln{L(\lambda)}}{\partial \lambda}\!=\; & -n +\sum_{i=1}^{n}X_{i} \frac{1}{\lambda} \end{aligned}\]

Igualando a cero y despejando \(\widehat{\lambda}\) tenemos:

\[\begin{aligned} -n +\sum_{i=1}^{n}X_{i} \frac{1}{\widehat{\lambda}}\!=\; & 0 \nonumber \\ \widehat{\lambda}\!=\; & \frac{\sum_{i=1}^{n}X_{i}}{n} \end{aligned}\]

Teniendo en cuenta que \(n=30\) y que se produjeron en total 102 siniestros, el valor estimado de \(\lambda\) es:

\[\begin{aligned} \widehat{\lambda}\!=\; & \frac{\sum_{i=1}^{n}x_{i}}{n}=\frac{102}{30}=3.4 \quad \text{llamadas de casos graves por día} \end{aligned}\]

Hay que recordar que, en esta distribución, una vez que se tiene la media, no es necesario calcular la varianza porque es igual a la media.

Problema Resuelto 1.5. Dada la función de verosimilitud conjunta5:

\[\begin{aligned} \label{act5_1} L(P)=C_{n}^{\sum X_{i}}P^{\sum X_{i}}(1-P)^{n-\sum X_{i}} \end{aligned}\] determine el estimador máximo verosímil de \(P\), es decir, de la proporción poblacional de éxitos.

Solución

Tomando logaritmo a la función de la ecuación [act5_1], tenemos:

\[\begin{aligned} \label{act5_2} \ln{L(P))}\!=\; & \ln{C_{n}^{\sum X_{i}}P^{\sum X_{i}}(1-P)^{n-\sum X_{i}}} \nonumber \\ \!=\; & \ln{C_{n}^{\sum X_{i}}}+\ln{P^{\sum X_{i}}}+(n-\sum X_{i})\ln{(1-P)} \end{aligned}\]

Derivando respecto de \(P\) la ecuación [act5_2] para calcular la condición de primer orden, nos queda

\[\begin{aligned} \frac{\partial \ln{L(P))}}{\partial P}\!=\; & \frac{\sum X_{i}}{P}-\frac{n-\sum X_{i}}{1-P} \end{aligned}\]

Igualando a cero y despejando \(\widehat{P}\) llegamos a:

\[\begin{aligned} \frac{\sum X_{i}}{\widehat{P}}-\frac{n-\sum X_{i}}{1-\widehat{P}}\!=\; & 0 \nonumber \\ \frac{\widehat{P}}{\sum X_{i}}\!=\; & \frac{1-\widehat{P}}{n-\sum X_{i}} \nonumber \\ \widehat{P}({n-\sum X_{i}})\!=\; & ({1-\widehat{P}}){\sum X_{i}} \nonumber \\ \widehat{P}\!=\; & \frac{\sum X_{i}}{n} \end{aligned}\]

Lo que nos dice que el estimador máximo verosímil de la proporción poblacional, es la proporción muestral.

Intervalos de Confianza

Cuando queremos hacer inferencia sobre algún parámetro poblacional, construimos un estimador que sea el adecuado para realizar la conjetura acerca del valor exacto del mismo. Sin embargo, esa estimación puntual del parámetro no da ningún tipo de información sobre el posible grado de “error” que podemos estar cometiendo, y es por ello que surge la noción de intervalo de confianza. Entonces, teniendo en cuenta el estimador, podemos construir un intervalo con el que vamos a decir que tenemos una cierta confianza de que el verdadero parámetro poblacional estará contenido en dicho intervalo. En este capítulo, y teniendo en cuenta las aplicaciones del TCL, vamos a desarrollar intervalos para los parámetros poblacionales media, proporción y varianza.

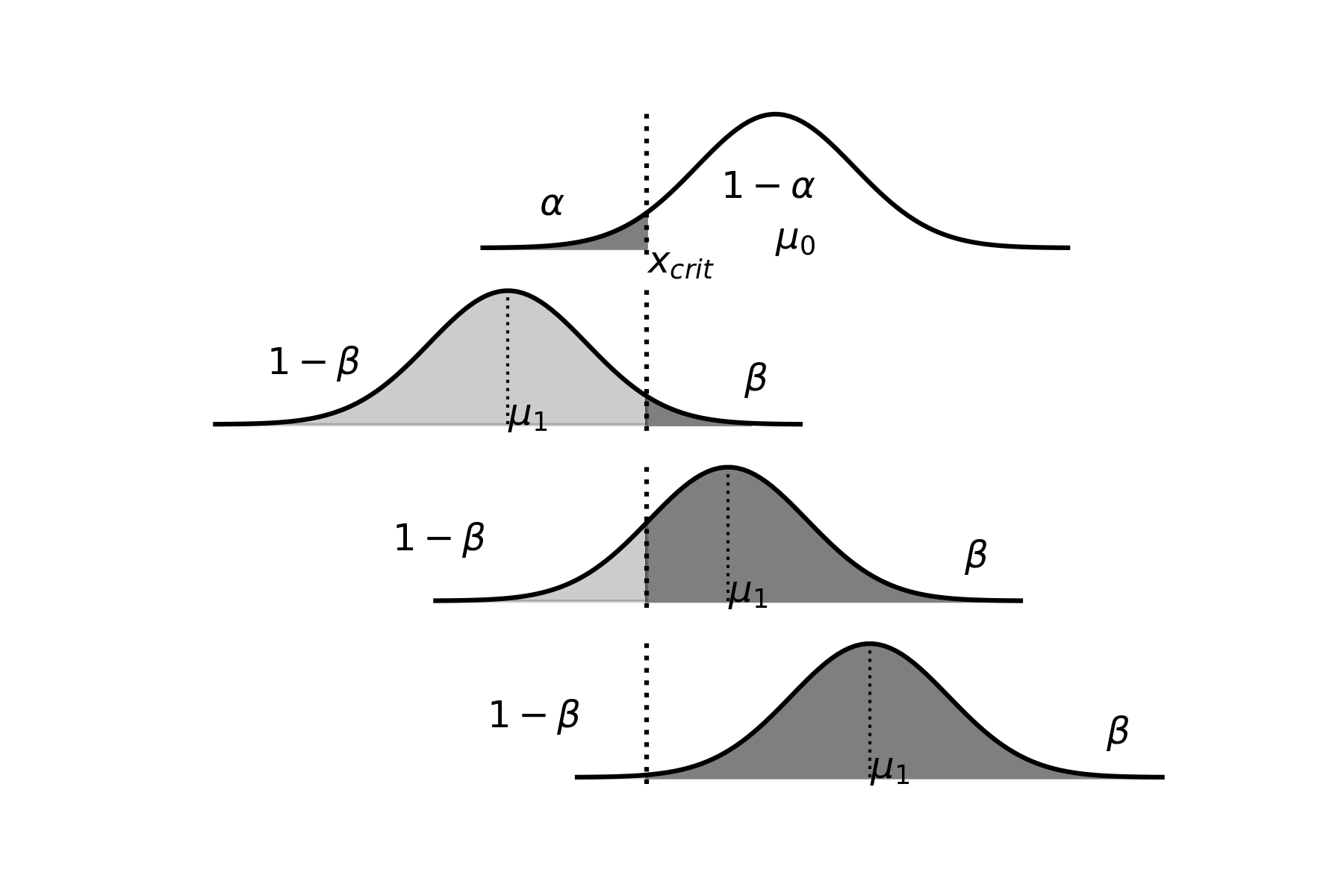

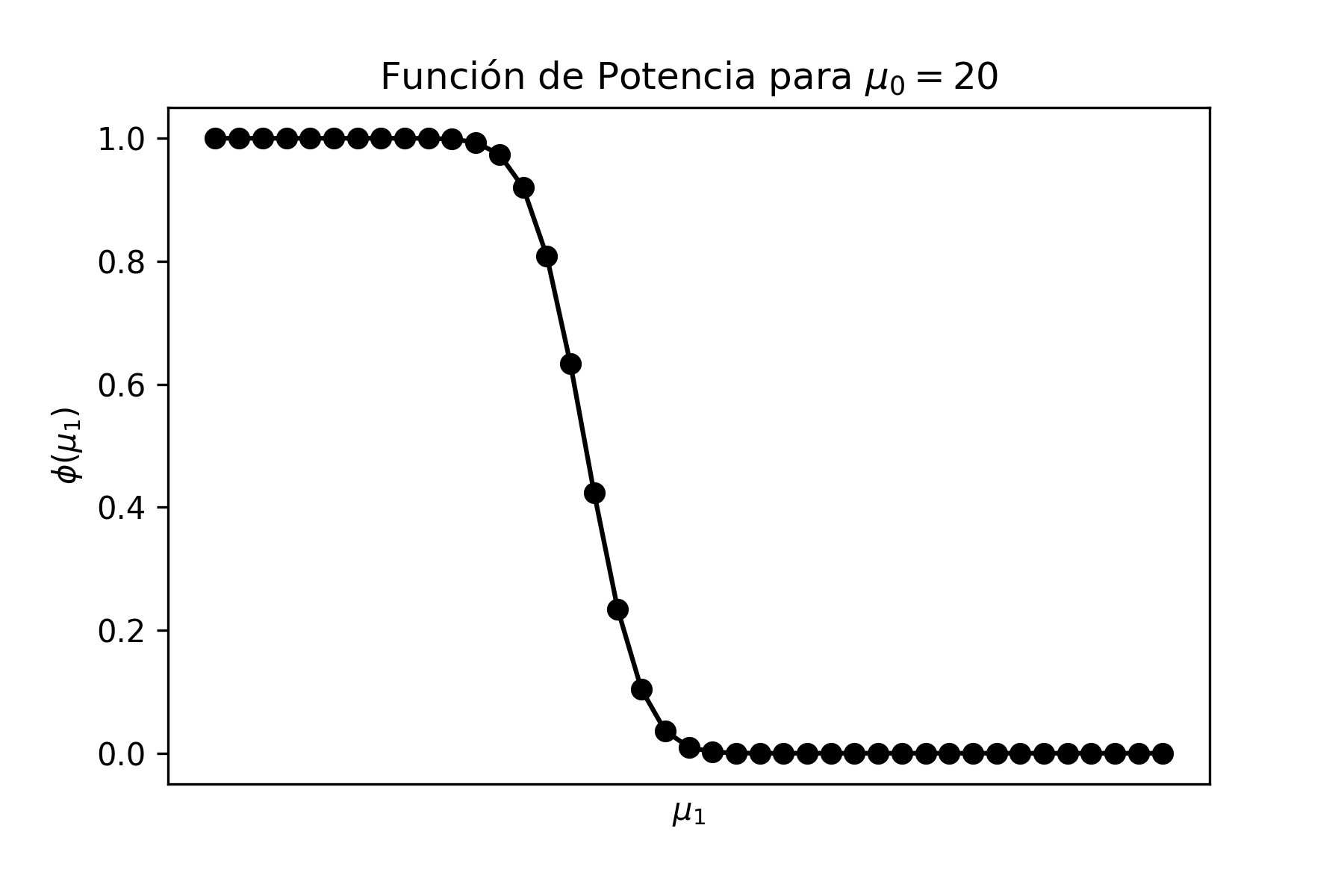

Definición 2.1 (Estimación por Intervalos). Una estimación de intervalo describe un rango de valores dentro del cual es posible, con un cierto nivel de confianza, que esté contenido el verdadero valor del parámetro poblacional que se desea averiguar.

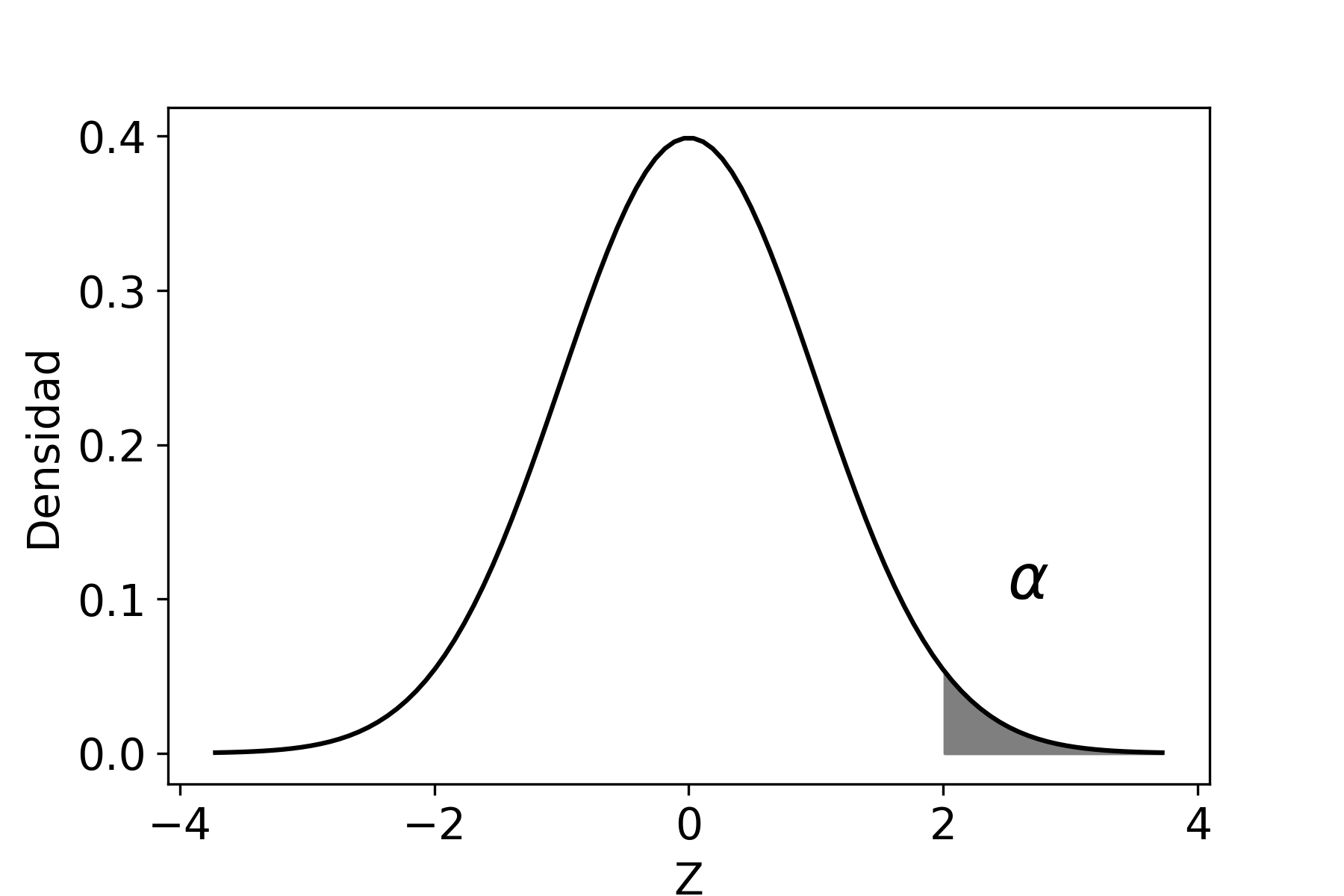

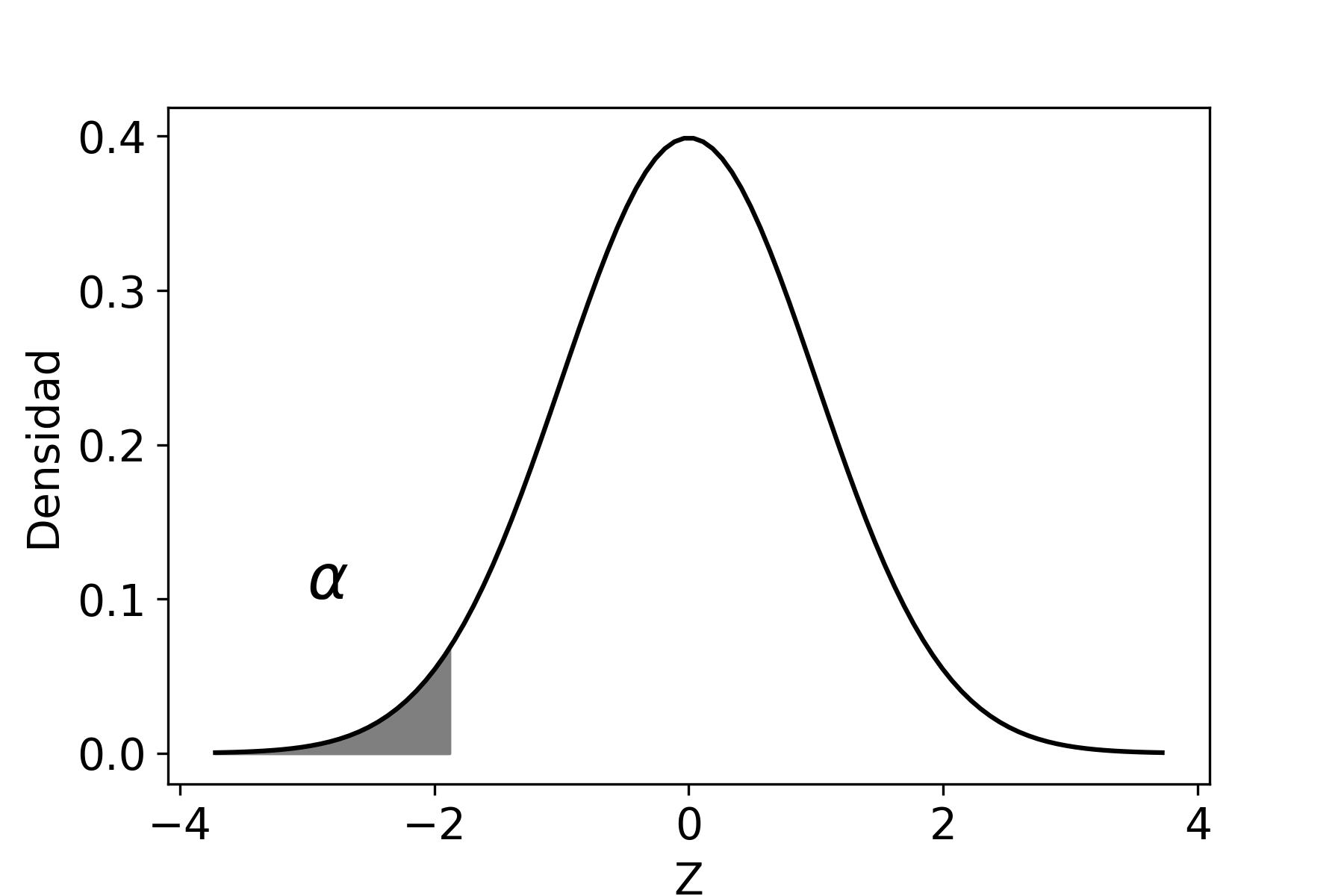

El nivel de confianza, que se denota como \((1-\alpha)\), es la probabilidad máxima con la que podríamos asegurar que el verdadero valor del parámetro poblacional se encuentra dentro de nuestro intervalo estimado.

El procedimiento consiste primero en realizar la estimación puntual del parámetro poblacional, luego calcular el error probable de esa estimación y, por último, determinar la confianza de que el intervalo contenga dicho valor del parámetro.

Intervalos para la Media Poblacional

Intervalos para la Media de una Población

Se distinguirán dos situaciones. Por un lado, cuando conocemos el valor de la varianza poblacional y, por el otro, cuando ese valor es desconocido.

Varianza conocida

Sea una variable aleatoria \(X\) con media \(\mu\) y varianza \(\sigma^{2}\), entonces por el TCL, cuando \(n\) es grande, tenemos que:

\[\begin{aligned} \label{z} \overline{X} & \sim & N(\mu,\sigma^{2}/n) \nonumber \\ \frac{\overline{X}-\mu}{\sigma/\sqrt{n}} & \sim & N(0,1) \end{aligned}\]

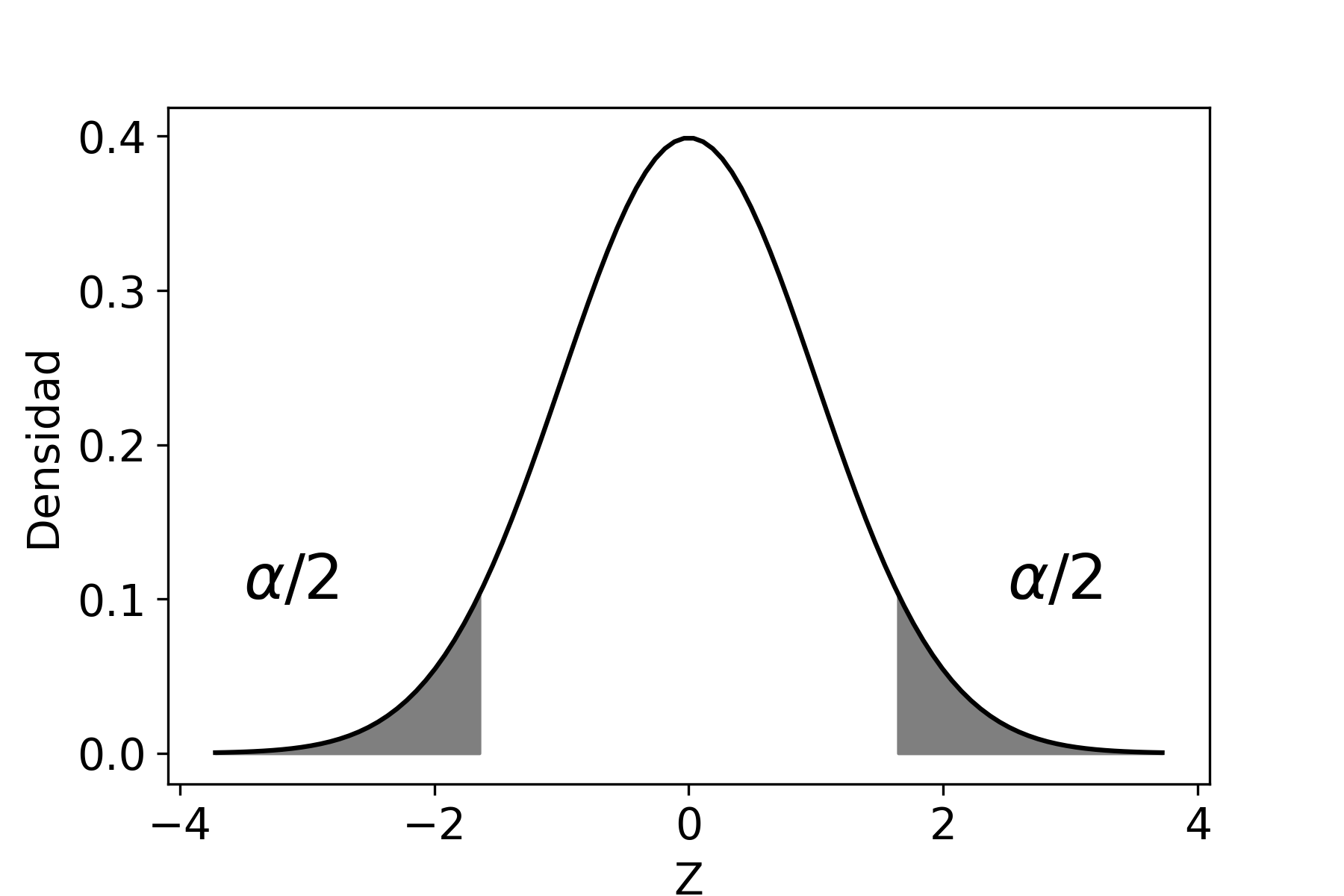

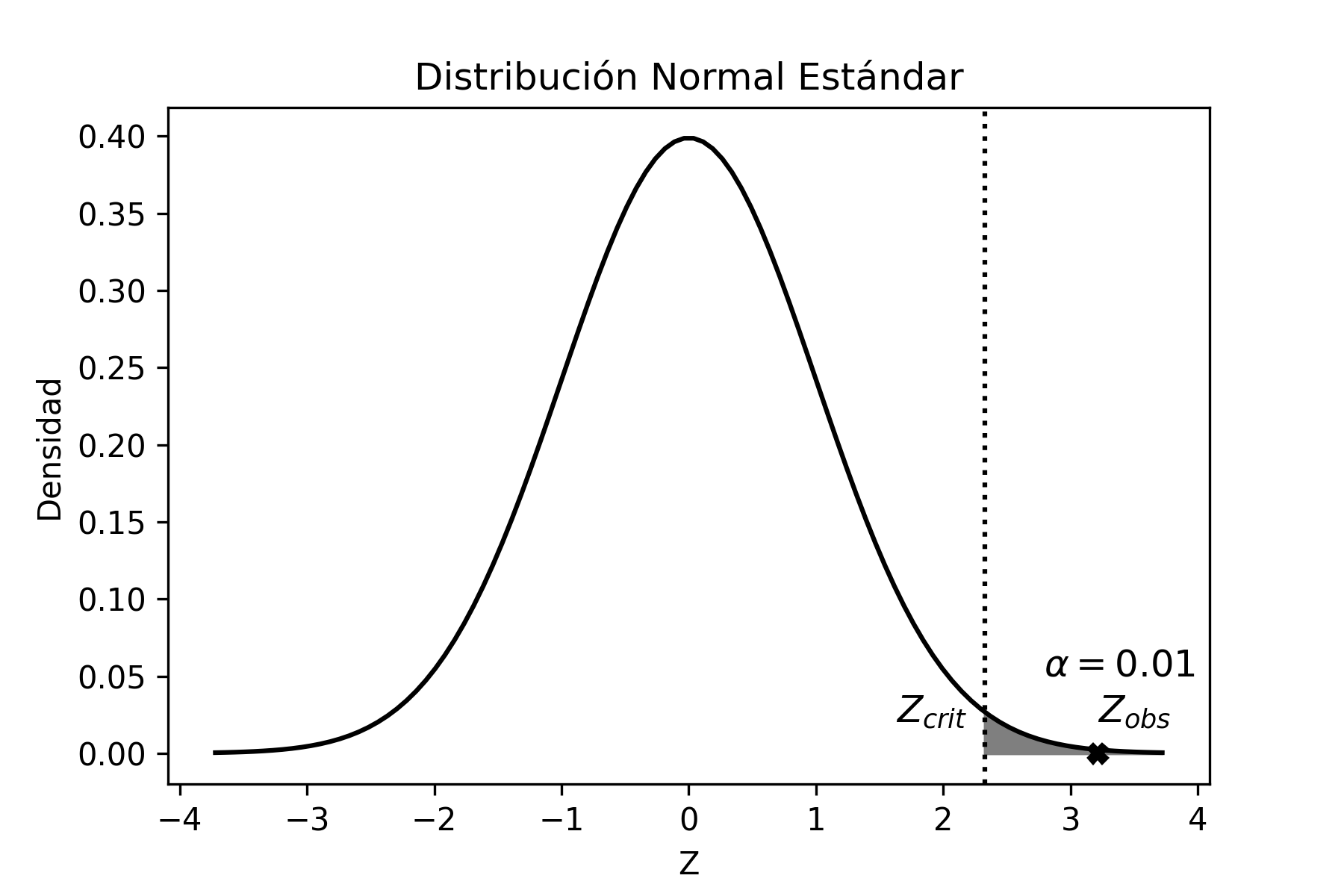

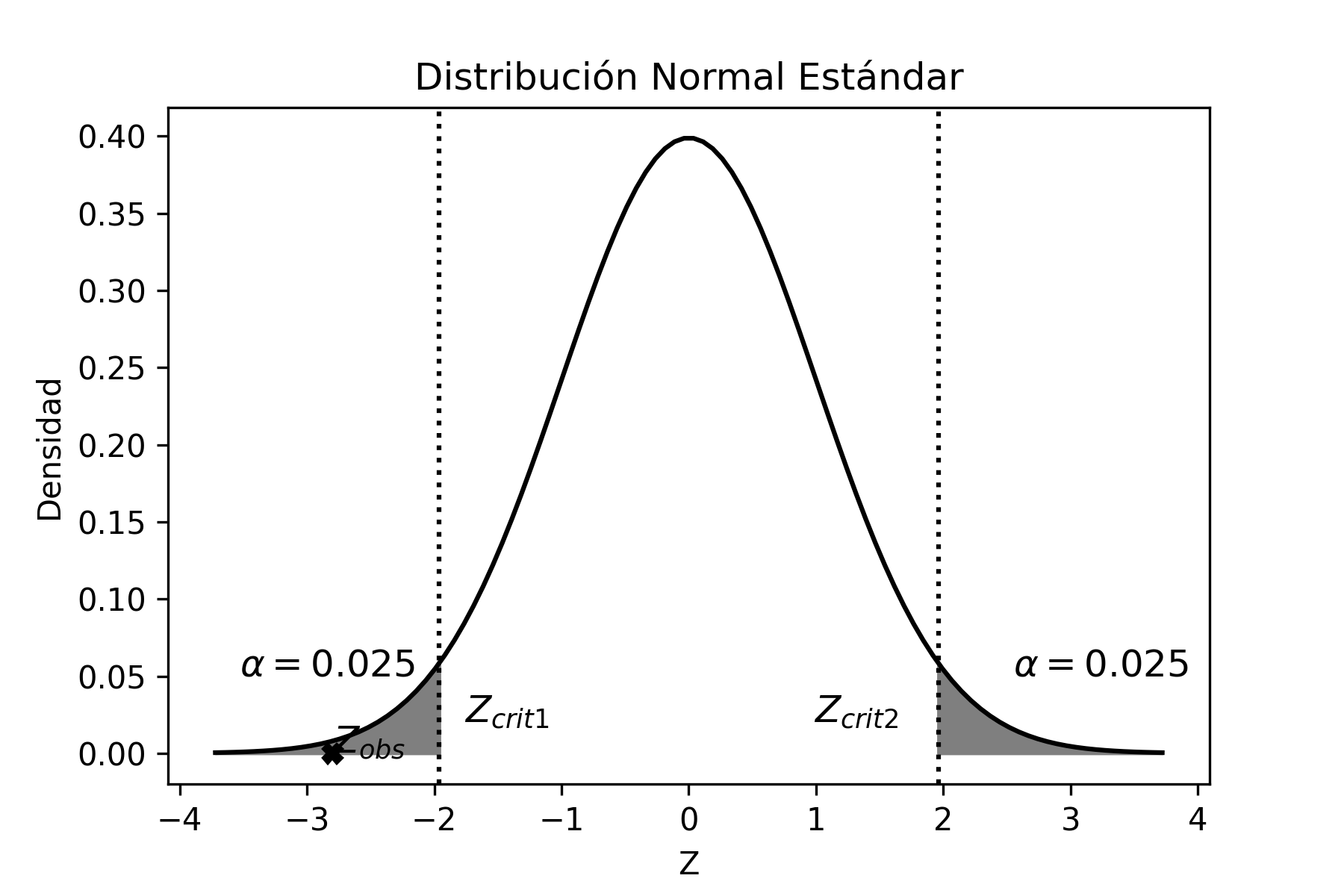

Ahora bien, podemos calcular la probabilidad acumulada entre dos puntos (que denotaremos como \(Z_{\alpha/2}\) y \(Z_{1-\alpha/2}\)) tal que dicha probabilidad sea igual a \(1-\alpha\), entonces:

\[\begin{aligned} P(Z_{\alpha/2}\leq Z \leq Z_{1-\alpha/2})\!=\; & 1-\alpha \end{aligned}\]

Reemplazando \(Z\) por el estadístico [z], tenemos:

\[\begin{aligned} \label{ic_z} P\bigg(Z_{\alpha/2}\leq \frac{\overline{X}-\mu}{\sigma/\sqrt{n}}\leq Z_{1-\alpha/2}\bigg)\!=\; & 1-\alpha \end{aligned}\]

Despejando \(\mu\) de la desigualdad contenida en el paréntesis de la ecuación anterior, obtenemos:

\[\begin{aligned} P\bigg(Z_{\alpha/2} \frac{\sigma}{\sqrt{n}} \leq \overline{X}-\mu \leq Z_{1-\alpha/2} \frac{\sigma}{\sqrt{n}}\bigg)\!=\; & 1-\alpha \nonumber \\ P\bigg(-\overline{X} + Z_{\alpha/2} \frac{\sigma}{\sqrt{n}} \leq -\mu\leq-\overline{X} + Z_{1-\alpha/2} \frac{\sigma}{\sqrt{n}}\bigg)\!=\; & 1-\alpha \nonumber \end{aligned}\] \[\label{ic_media} {P\bigg(\overline{X} - Z_{1-\alpha/2} \frac{\sigma}{\sqrt{n}} \leq \mu \leq \overline{X} - Z_{\alpha/2} \frac{\sigma}{\sqrt{n}}\bigg)=1-\alpha}\]

En la última igualdad, la expresión contenida en el paréntesis de la probabilidad nos determina los límites inferior y superior del intervalo para la media, que llamaremos intervalo de confianza, . Con lo cual se puede afirmar que existe una probabilidad de \(1-\alpha\) que el intervalo de confianza contenga el verdadero valor de la media poblacional.

El proceso para llegar a esa expresión es la que utilizaremos en lo sucesivo para construir los intervalos de confianza de los parámetros poblacionales, con el cambio que corresponda, según sea la distribución asociada que tenga el estimador utilizado en el análisis.

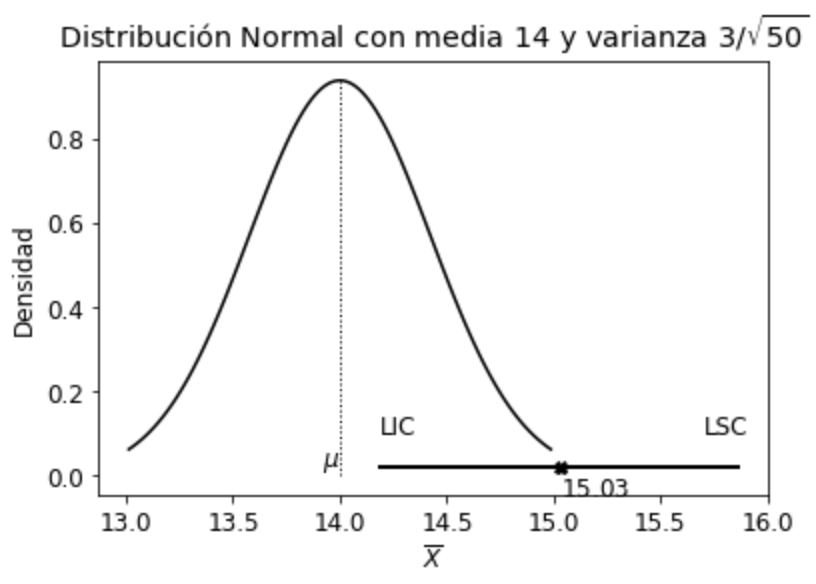

Problema Resuelto 2.1. Una empresa que vende agroquímicos para los cultivos quiere saber la cantidad mensual, en promedio por cliente, que vende de un agroquímico específico para el cultivo de soja. Para ello, toma una muestra al azar de 50 clientes y encuentra que, en promedio, vendió \(15.03\) dosis. Si sabe por estudios anteriores que la población se distribuye aproximadamente normal con una desviación estándar de 3 dosis, se pide:

Hallar un intervalo de confianza del 95% para la media de la venta mensual de dicho agroquímico

Si luego se conociera que la media poblacional es de 14 dosis, ¿qué pudo haber pasado?

Hallar un intervalo de confianza del 99%. Explicar la diferencia con el obtenido en el primer punto

Solución

Para calcular el intervalo de confianza del 95% para la media, y debido a que se trata de una población aproximadamente normal6, entonces podemos afirmar que:

\[\begin{aligned} \overline{x} - Z_{1-\alpha/2} \frac{\sigma}{\sqrt{n}} \leq &\mu& \leq \overline{x} - Z_{\alpha/2} \frac{\sigma}{\sqrt{n}} \nonumber \\ 15.03 - 1.96 \frac{3}{\sqrt{50}} \leq & \mu & \leq 15.03 - (-1.96) \frac{3}{\sqrt{50}} \nonumber \\ 14.19 \leq & \mu & \leq 15.86 \end{aligned}\]

Como conclusión, podemos decir que el intervalo construido con la muestra extraída contendrá, con un 95% de confianza, el verdadero valor del parámetro poblacional (en este caso, la media). Hay que destacar que extraemos una única muestra, que proviene del universo que contiene todas las muestras posibles de tamaño \(n\) (en este caso \(n=50\)), que se pueden formar con los elementos de la población con dispersión \(\sigma^{2}\) (en este caso \(\sigma^{2}=9\)). De ese universo que, en general, es muy grande podría haber sido seleccionada cualquier otra muestra, en lugar de la que extrajimos. En ese caso hubiésemos construido un intervalo de confianza diferente. Es importante entonces conocer, de antemano, que en ese gran universo de muestras posibles, el 95% de ellas nos conducen a construir un intervalo de confianza que contiene el verdadero valor del parámetro poblacional y que el 5% restante nos llevan, en cambio, a plantear un intervalo que no contiene el verdadero valor del parámetro poblacional. En otros términos, en promedio, de cada cien muestras posibles, 95 nos conducirán a una inferencia correcta acerca del parámetro poblacional, mientras las otras 5 nos llevarán a una predicción errónea. Esto es precisamente el significado del nivel de confianza.

Ahora bien, si luego se conoce que la media poblacional es 14 dosis, pueden haber sucedido básicamente dos cosas: o que tuvimos “mala suerte” y sacamos una muestra aleatoria (que tiene sólo el 5% de probabilidad de presentarse), cuyo intervalo no contiene la media poblacional y, por lo tanto, nos condujo a realizar una inferencia incorrecta; o bien que hay un problema de muestreo, como podría ser que la selección no fue aleatoria, que la medición de la cantidad de dosis de agroquímicos no fue correctamente realizada, etc.

Gráficamente, la situación hubiese sido:

Se puede observar claramente que el intervalo de confianza no incluye al verdadero valor del parámetro poblacional (\(\mu=14\)).

Si consideramos un nivel de confianza del 99%, el intervalo es:

\[\begin{aligned} \overline{x} - Z_{1-\alpha/2} \frac{\sigma}{\sqrt{n}} \leq &\mu& \leq \overline{x} - Z_{\alpha/2} \frac{\sigma}{\sqrt{n}} \nonumber \\ 15.03 - 2.58 \frac{3}{\sqrt{50}} \leq & \mu & \leq 15.03 - (-2.58) \frac{3}{\sqrt{50}} \nonumber \\ 13.93 \leq & \mu & \leq 16.12 \end{aligned}\]

Como podemos ver, el intervalo de confianza es más amplio que el anterior, es decir perdemos precisión para poder tener mayor confianza. En este último caso, si la media poblacional hubiese sido igual a 14, entonces el intervalo hubiese contenido al valor del parámetro poblacional a un nivel de confianza del 99%.

Sólo es posible aumentar la precisión y el nivel de confianza simultáneamente tomando una muestra de mayor tamaño.

Para calcular el intervalo de confianza con Python usamos el siguiente código:

# Librerias

import numpy as np

from scipy import stats

from scipy.stats import norm

from statsmodels.stats import weightstats as stests

import statistics

from statistics import stdev

# Nivel de confianza

nivel_conf=0.95

# Varianza poblacional

var=3**2

# Datos muestrales

data=[13.68,13.57,10.26,12.4,16.99,13.98,16.13,19.23,17.76,16.1,

16.79,11.54,17.62,14.17,17.02,13.12,13.97,16.69,13.62,15.58,

12.4,14.92,16.74,15.39,13.42,15.67,15.25,15.35,15.35,14.52,

15.42,16.47,12.91,16.17,13.65,14.67,13.94,15.03,16.01,15.75,

16.28,16.22,15.77,13.95,16.24,14.63,12.36,15.08,17.19,14.52]

def ic(data,var,nivel_conf):

n = len(data)

z = norm.ppf(nivel_conf+(1-nivel_conf)/2)

data_mean = np.mean(data)

data_sd = stdev( data, data_mean )

sigma=np.sqrt(var)

lim_inf=data_mean-z*sigma/n**0.5

lim_sup=data_mean+z*sigma/n**0.5

return lim_inf,lim_sup,z,data_mean,data_sd,n

lim_inf,lim_sup,z,data_mean,data_sd,n = ic(data,var,nivel_conf)

print("Media Muestral =",data_mean)

print("S Muestral =",data_sd)

print("n muestral =",n)

print("z =", z)

print("Intervalo de confianza: ","[",lim_inf,";",lim_sup,"]")

Media Muestral = 15.0298

S Muestral = 1.7327063766706414

n muestral = 50

z = 1.959963984540054

Intervalo de confianza: [ 14.198257705390192 ; 15.861342294609807 ]Varianza desconocida

Para estimar intervalos de confianza para la media cuando la varianza poblacional es desconocida y la población es normal, se debe que usar el estadístico \(t\) (ver [estadistico_t]), es decir:

\[\begin{aligned} \frac{\overline{X}-\mu}{S/\sqrt{n}} \sim t_{n-1} \end{aligned}\]

Problema Resuelto 2.2. Una empresa dedicada a la fabricación de pilas recargables desea estimar, con un nivel de confianza del 95%, la duración media, medida en ciclos, de un tipo nuevo de pilas para iniciar una campaña publicitaria. Con ese objetivo, toma una muestra aleatoria de \(n=10\) pilas y obtiene los siguientes resultados:

| Media Muestral | 733 |

| Desviación estándar Muestral | 112 |

Suponer población normal para la duración de los ciclos de las pilas.

Solución

Por ser la varianza desconocida, la población normal y \(n\) pequeño, al intervalo de confianza para la media poblacional lo construimos con el estadístico de la distribución \(t\):

\[\begin{aligned} P(t_{n-1;\alpha/2}\leq t_{n-1} \leq t_{n-1;1-\alpha/2})\!=\; & 1-\alpha \nonumber \\ P\bigg(t_{n-1;\alpha/2}\leq \frac{\overline{X}-\mu}{S/\sqrt{n}}\leq t_{n-1;1-\alpha/2}\bigg)\!=\; & 1-\alpha \end{aligned}\]

Despejando \(\mu\) dentro del paréntesis de la ecuación anterior, tenemos:

\[\begin{aligned} P\bigg(t_{n-1;\alpha/2} \frac{S}{\sqrt{n}} \leq \overline{X}-\mu \leq t_{n-1;1-\alpha/2} \frac{S}{\sqrt{n}}\bigg)\!=\; & 1-\alpha \nonumber \\ P\bigg(-\overline{X} + t_{n-1;\alpha/2} \frac{S}{\sqrt{n}} \leq -\mu\leq-\overline{X} + t_{n-1;1-\alpha/2} \frac{S}{\sqrt{n}}\bigg)\!=\; & 1-\alpha \nonumber \end{aligned}\] \[{P\bigg(\overline{X} - t_{n-1;1-\alpha/2} \frac{S}{\sqrt{n}} \leq \mu \leq \overline{X} - t_{n-1;\alpha/2} \frac{S}{\sqrt{n}}\bigg)=1-\alpha}\]

Teniendo en cuenta que la media muestral es \(733\), el tamaño de muestra 10, y la desviación muestral \(112\), el intervalo que resulta es:

\[\begin{aligned} \overline{x} - t_{n-1;1-\alpha/2} \frac{s}{\sqrt{n}} \leq &\mu& \leq \overline{x} - t_{n-1;\alpha/2} \frac{s}{\sqrt{n}} \nonumber \\ 733 - 2.262 \frac{112}{\sqrt{10}} \leq & \mu & \leq 733 - (-2.262) \frac{112}{\sqrt{10}} \nonumber \\ 652.89 \leq & \mu & \leq 813.11 \end{aligned}\]

Como conclusión, podemos decir que tenemos una confianza del 95% que el verdadero valor del parámetro poblacional (\(\mu\)) estará entre \(652.89\) y \(813.11\), o sea que la duración media de las pilas, medida en ciclos, estará entre estos dos valores.

Si la población no es normal se presentan las siguientes opciones:

Con \(n\) pequeño habría que tratar de transformar la variable para que la distribución poblacional se aproxime a una normal. En numerosas ocasiones, la transformación logarítmica o raíz cuadrada suele ser óptima.

Si la muestra es lo suficientemente grande, y teniendo en cuenta que \(S\) es un estimador consistente de \(\sigma\), se puede usar el estadístico \(Z=\frac{\overline{X}-\mu}{\sigma/\sqrt{n}}\)

Si la muestra es chica, y no se puede transformar la variable para que, en la población, se distribuya aproximadamente normal, se deberá recurrir a la desigualdad de Chebycheff, con la que se podrá obtener una cota máxima para la probabilidad que la media muestral difiera, en valor absoluto, respecto de la media poblacional en más de un cierto valor. Para ello es suficiente con conocer \(\sigma\), o tener una aproximación de su valor.

Intervalos para la Diferencia de Medias de dos Poblaciones

Se tienen dos poblaciones de las que se extrae una muestra de cada una de ellas. Se deben distinguir los casos según las muestras sean independientes o no, y según sus varianzas poblacionales sean conocidas o no.

Muestras independientes con varianzas conocidas

Sean dos variables aleatorias \(X_{1}\) y \(X_{2}\) que se distribuyen normalmente, entonces, por el TCL podemos escribir:

\[\begin{aligned} \overline{X}_{1} &\sim& N(\mu_{1},\sigma_{1}^{2}/n_{1}) \nonumber \\ \overline{X}_{2} &\sim& N(\mu_{2},\sigma_{2}^{2}/n_{2}) \end{aligned}\]

Restando ambas variables y estandarizando tenemos:

\[\begin{aligned} \label{iic_z2mi} \overline{X}_{1} -\overline{X}_{2} &\sim& N \bigg(\mu_{1}-\mu_{2},\sigma_{1}^{2}/n_{1} +\sigma_{2}^{2}/n_{2} \bigg) \nonumber \\ \frac{(\overline{X}_{1} -\overline{X}_{2})-(\mu_{1}-\mu_{2})}{\sqrt{\sigma_{1}^{2}/n_{1} +\sigma_{2}^{2}/n_{2}}} &\sim & N(0,1) \end{aligned}\]

Esto es así porque la suma (diferencia) de variables que son independientes y de distribución normal es otra variable que también se distribuye normalmente, con media igual a la suma (diferencia) de las medias y varianza igual a la suma de varianzas. El intervalo de confianza se construye utilizando este estadístico.

Problema Resuelto 2.3. Los directores de una empresa dedicada a la fabricación de dispositivos de almacenamiento digital deben decidir la implementación (o no) de un nuevo proceso que aumentaría la velocidad de acceso de los dispositivos a los datos almacenados en los mismos. Es por ello, que quieren saber si la velocidad es superior en el nuevo proceso en relación al proceso antiguo. Para ello, el departamento de calidad de la empresa tomó dos muestras de dispositivos de almacenamiento y les aplicó, a una el proceso antiguo y a la otra el nuevo proceso, obteniéndose los siguientes resultados:

| Proceso antiguo | Proceso nuevo | |

|---|---|---|

| n | 100 | 150 |

| \(\sum_{i}x_{i}\) (Mbytes/s) | 56 000 | 85 515 |

Además, se conoce que:

| Proceso antiguo | Proceso nuevo | |

|---|---|---|

| \(\sigma\) | 50 | 60 |

A partir de la construcción de un intervalo de confianza con \(1-\alpha=0.95\), ¿a qué conclusión se llega?

Solución

Teniendo en cuenta la ecuación [iic_z2mi], dado que estamos trabajando con dos muestras independientes, entonces podemos escribir:

\[\begin{aligned} P(Z_{\alpha/2}\leq Z \leq Z_{1-\alpha/2})\!=\; & 1-\alpha \nonumber \\ P\bigg(Z_{\alpha/2}\leq \frac{(\overline{X}_{1} -\overline{X}_{2})-(\mu_{1}-\mu_{2})}{\sqrt{\sigma_{1}^{2}/n_{1} +\sigma_{2}^{2}/n_{2}}}\leq Z_{1-\alpha/2}\bigg)\!=\; & 1-\alpha \end{aligned}\]

Operando sobre la desigualdad anterior, tenemos:

\[\begin{aligned} P\bigg(Z_{\alpha/2} \sqrt{\sigma_{1}^{2}/n_{1} +\sigma_{2}^{2}/n_{2}} \leq (\overline{X}_{1} -\overline{X}_{2})-(\mu_{1}-\mu_{2}) \leq Z_{1-\alpha/2} \sqrt{\sigma_{1}^{2}/n_{1} +\sigma_{2}^{2}/n_{2}} \bigg)=1-\alpha \nonumber \\ P\bigg(-(\overline{X}_{1} -\overline{X}_{2})+Z_{\alpha/2} \sqrt{\frac{\sigma_{1}^{2}}{n_{1}} +\frac{\sigma_{2}^{2}}{n_{2}}} \leq -(\mu_{1}-\mu_{2}) \leq -(\overline{X}_{1} -\overline{X}_{2})+Z_{1-\alpha/2} \sqrt{\frac{\sigma_{1}^{2}}{n_{1}} +\frac{\sigma_{2}^{2}}{n_{2}}} \bigg)=1-\alpha \nonumber \end{aligned}\] \[{P\bigg((\overline{X}_{1} -\overline{X}_{2})-Z_{1-\alpha/2} \sqrt{\frac{\sigma_{1}^{2}}{n_{1}} +\frac{\sigma_{2}^{2}}{n_{2}}} \leq (\mu_{1}-\mu_{2}) \leq (\overline{X}_{1} -\overline{X}_{2})-Z_{\alpha/2} \sqrt{\frac{\sigma_{1}^{2}}{n_{1}} +\frac{\sigma_{2}^{2}}{n_{2}}} \bigg)= 1-\alpha}\]

Como se observa, tenemos el intervalo de confianza para la diferencia de medias poblacionales, es decir para \((\mu_{1}-\mu_{2})\).

Teniendo en cuenta que, en este caso, las medias muestrales son iguales a:

\[\begin{aligned} \overline{x}_{1}\!=\; & \frac{\sum_{i}x_{1i}}{n_{1}}=\frac{56\,000}{100}=560 \nonumber \\ \overline{x}_{2}\!=\; & \frac{\sum_{i}x_{2i}}{n_{2}}=\frac{85\,515}{150}=570.1 \end{aligned}\] expresadas en \(Mbytes/s\), podemos calcular el intervalo de confianza como:

\[\begin{aligned} (\overline{x}_{1} -\overline{x}_{2})-Z_{1-\alpha/2} \sqrt{\frac{\sigma_{1}^{2}}{n_{1}} +\frac{\sigma_{2}^{2}}{n_{2}}} \leq &(\mu_{1}-\mu_{2}) &\leq (\overline{x}_{1} -\overline{x}_{2})-Z_{\alpha/2} \sqrt{\frac{\sigma_{1}^{2}}{n_{1}} +\frac{\sigma_{2}^{2}}{n_{2}}} \nonumber \\ (560 -570.1)-1.96 \sqrt{\frac{50^{2}}{100} +\frac{60^{2}}{150}} \leq & (\mu_{1}-\mu_{2}) & \leq (560 -570.1)-(-1.96) \sqrt{\frac{50^{2}}{100} +\frac{60^{2}}{150}} \nonumber \\ -23.82 \leq & (\mu_{1}-\mu_{2}) & \leq 3.62 \nonumber \\ \end{aligned}\]

Como el valor \((\mu_{1}-\mu_{2})=0\) está incluido en el intervalo que obtuvimos, es decir, es uno de los valores que podría tomar la diferencia de medias de las poblaciones (con un nivel de confianza del 95%), entonces la conclusión es que no existen diferencias estadísticamente significativas entre las velocidades de acceso de ambos dispositivos.

Muestras independientes con varianzas desconocidas

Cuando estamos en presencia de una estimación por intervalos de confianza de una diferencia de medias con varianzas desconocidas, se debe buscar un estadístico que cumpla la condición de no contener las varianzas poblacionales. Sabiendo que una variable aleatoria con distribución \(t\) se define como:

\[\begin{aligned} \label{def_t} \frac{Z}{\sqrt{\frac{U}{n-1}}} \sim t_{n-1} \end{aligned}\] y que además la suma de dos estadísticos con distribuciones \(\chi^{2}_{n_{1}-1}\) y \(\chi^{2}_{n_{2}-1}\) nos da como resultado otra distribución \(\chi^{2}_{n_{1}+n_{2}-2}\), es decir que:

\[\begin{aligned} \label{sum_chi} \chi^{2}_{n_{1}-1} + \chi^{2}_{n_{2}-1} &\sim & \chi^{2}_{n_{1}+n_{2}-2} \nonumber \\ \frac{(n_{1}-1)S^{2}_{1}}{\sigma^{2}_{1}}+\frac{(n_{2}-1)S^{2}_{2}}{\sigma^{2}_{2}} &\sim & \chi^{2}_{n_{1}+n_{2}-2} \end{aligned}\] entonces, podemos utilizar [iic_z2mi] y [sum_chi] para reemplazar, respectivamente el numerador y el denominador en [def_t]

\[\begin{aligned} \frac{Z}{\sqrt{\frac{U}{n-1}}} &\sim & t_{n-1} \nonumber \\ \frac{\frac{(\overline{X}_{1} -\overline{X}_{2})-(\mu_{1}-\mu_{2})}{\sqrt{\sigma^{2}_{1}/n_{1} +\sigma^{2}_{2}/n_{2}}}}{\sqrt{\frac{\frac{(n_{1}-1)S^{2}_{1}}{\sigma^{2}_{1}}+\frac{(n_{2}-1)S^{2}_{2}}{\sigma^{2}_{2}}}{n_{1}+n_{2}-2}}} &\sim & t_{n_{1}+n_{2}-2} \end{aligned}\]

Bajo el supuesto de que las varianzas poblacionales son iguales, es decir \(\sigma^{2}_{1}=\sigma^{2}_{2}=\sigma^{2}\), entonces podemos escribir la expresión anterior como:

\[\begin{aligned} \label{estadistico_t2mi} \frac{\frac{(\overline{X}_{1} -\overline{X}_{2})-(\mu_{1}-\mu_{2})}{\sqrt{\sigma^{2}/n_{1} +\sigma^{2}/n_{2}}}}{\sqrt{\frac{\frac{(n_{1}-1)S^{2}_{1}}{\sigma^{2}}+\frac{(n_{2}-1)S^{2}_{2}}{\sigma^{2}}}{n_{1}+n_{2}-2}}} &\sim & t_{n_{1}+n_{2}-2} \nonumber \\ \frac{(\overline{X}_{1} -\overline{X}_{2})-(\mu_{1}-\mu_{2})}{\sqrt{S^{2}_{p} (\frac{1}{n_{1}}+\frac{1}{n_{2}})}} &\sim & t_{n_{1}+n_{2}-2} \end{aligned}\] que es el estadístico que se utiliza para construir el intervalo de confianza, donde \(S^{2}_{p}=\frac{(n_{1}-1)S^{2}_{1}+(n_{2}-1)S^{2}_{2}}{n_{1}+n_{2}-2}\) es la varianza de la diferencia de medias, que contiene la media ponderada de las varianzas muestrales.

Problema Resuelto 2.4. El gerente de una empresa, que posee estaciones de servicios en distintas ciudades del país, piensa que las medias de la venta diaria de combustible del tipo premium (medido en litros), de las dos principales ciudades del país, son diferentes. Para saber si esto es así, se toman muestras aleatorias de 9 casos cada una, con los siguientes resultados:

| Caso | Ciudad A | Caso | Ciudad B | |

|---|---|---|---|---|

| 1 | 270,0 | 1 | 350,0 | |

| 2 | 160,0 | 2 | 600,3 | |

| 3 | 357,4 | 3 | 424,9 | |

| 4 | 100,0 | 4 | 300,0 | |

| 5 | 283,2 | 5 | 490,3 | |

| 6 | 250,0 | 6 | 490,2 | |

| 7 | 130,0 | 7 | 404,2 | |

| 8 | 200,2 | 8 | 404,2 | |

| 9 | 154,8 | 9 | 388,8 | |

| \(\overline{X}\) | 211,7 | \(\overline{X}\) | 428,1 | |

| \(S\) | 83,97 | \(S\) | 88,45 |

Con un nivel de confianza del 99%, se pide que opine sobre lo que piensa el gerente de la empresa

Solución

Partiendo de que estamos ante la presencia de una estimación por intervalo de confianza de diferencia de medias con muestras independientes, y con las varianzas poblacionales desconocidas pero que se suponen son iguales, entonces usamos el estadístico [estadistico_t2mi]. Es decir:

\[\begin{aligned} &&P\bigg(t_{n_{1}+n_{2}-2}^{\alpha/2} \leq t \leq t_{n_{1}+n_{2}-2}^{1-\alpha/2}\bigg)=1-\alpha \nonumber \\ &&P\bigg(t_{n_{1}+n_{2}-2}^{\alpha/2}\leq \frac{(\overline{X}_{1} -\overline{X}_{2})- (\mu_{1}-\mu_{2}) }{\sqrt{S^{2}_{p} (\frac{1}{n_{1}}+\frac{1}{n_{2}})}} \leq t_{n_{1}+n_{2}-2}^{1-\alpha/2}\bigg)=1-\alpha \nonumber \\ &&P\bigg(t_{n_{1}+n_{2}-2}^{\alpha/2} \sqrt{S^{2}_{p} (\frac{1}{n_{1}}+\frac{1}{n_{2}})} \leq (\overline{X}_{1} - \overline{X}_{2})- (\mu_{1}-\mu_{2}) \leq t_{n_{1}+n_{2}-2}^{1-\alpha/2} \sqrt{S^{2}_{p} (\frac{1}{n_{1}}+\frac{1}{n_{2}})}\bigg) =1-\alpha \nonumber \\ &&P\bigg(-(\overline{X}_{1} -\overline{X}_{2})+t_{n_{1}+n_{2}-2}^{\alpha/2} S^{*}_{p} \leq -(\mu_{1}-\mu_{2}) \leq -(\overline{X}_{1} -\overline{X}_{2})+ t_{n_{1}+n_{2}-2}^{1-\alpha/2}) S^{*}_{p}\bigg) =1-\alpha \nonumber \end{aligned}\] \[{P\bigg((\overline{X}_{1} -\overline{X}_{2})-t_{n_{1}+n_{2}-2}^{1-\alpha/2} S^{*}_{p} \leq (\mu_{1}-\mu_{2}) \leq (\overline{X}_{1} -\overline{X}_{2})- t_{n_{1}+n_{2}-2}^{\alpha/2} S^{*}_{p}\bigg) =1-\alpha}\] donde \(S^{*}_{p}=\sqrt{S^{2}_{p} (\frac{1}{n_{1}}+\frac{1}{n_{2}})}\).

Teniendo en cuenta que \(t_{9+9-2}^{0.995}=2.92\), entonces podemos plantear el intervalo de confianza como:

\[\begin{aligned} (\overline{x}_{1} -\overline{x}_{2})-t_{n_{1}+n_{2}-2}^{1-\alpha/2} s^{*}_{p} \leq &(\mu_{1}-\mu_{2})& \leq (\overline{x}_{1} -\overline{x}_{2})- t_{n_{1}+n_{2}-2}^{\alpha/2} s^{*}_{p} \nonumber \\ (211.7 -428.1)-2.92 \sqrt{7\,436,6 (\frac{1}{9}+\frac{1}{9})} \leq & (\mu_{1}-\mu_{2}) & \leq (211.7 -428.1)-(- 2.92) \sqrt{7\,436,6(\frac{1}{9}+\frac{1}{9})} \nonumber \\ -410.2 \leq & (\mu_{1}-\mu_{2}) & -22.5 \nonumber \\ \end{aligned}\] donde \(S^{2}_{p}=7\,436,6\).

Conclusión: podemos decir que, dado que el intervalo de confianza no incluye el valor cero, hay evidencia estadística para afirmar que la venta de combustible premium es diferente en las dos ciudades, con lo que el gerente estaría en lo correcto.

Muestras dependientes

Cuando trabajamos con dos muestras dependientes, o sea, que tenemos fundamentos para pensar que los valores de ambas variables están relacionados, no se puede usar ninguno de los estadísticos anteriores, ya que fueron deducidos bajo el supuesto de que las variables eran independientes.

Supongamos dos variables \(X_{1}\) y \(X_{2}\) las cuales son dependientes. Se define entonces una nueva variable como la diferencia entre ambas, es decir:

\[\begin{aligned} d=X_{1}-X_{2} \end{aligned}\]

A la variable \(d\) se le puede calcular su media muestral \(\overline{d}\) y su respectiva desviación estándar muestral \(S_{d}\). Entonces, el estadístico que se usa para crear el intervalo de confianza sobre la media con muestras dependientes es:

\[\begin{aligned} \label{est_m2md} \frac{\overline{d}-\delta}{S_{d}/\sqrt{n}} \sim t_{n-1} \end{aligned}\] donde \(\delta\) es el parámetro poblacional de la diferencia de medias de ambas variables en la población y \(d\) es estimador de dicho parámetro. El estadístico [est_m2md] es el que se utiliza para confeccionar el intervalo de confianza, en este caso.

Problema Resuelto 2.5. Una empresa que se dedica a la fabricación de bicicletas, desea comparar el desgaste de dos tipos de cubiertas. Para realizar la comparación se colocan en la rueda trasera de cada una de 12 bicicletas una cubierta de un tipo y en la delantera la del otro tipo. Luego, se recorre una cierta cantidad de kilómetros preestablecidos para cada bicicleta y se registra el desgaste de cada cubierta, medido en milímetros de pérdida de espesor. En la siguiente tabla se presentan los resultados obtenidos:

| Bicicleta | Cubierta I | Cubierta II |

|---|---|---|

| 1 | 7,3 | 12,0 |

| 2 | 9,8 | 10,5 |

| 3 | 8,6 | 9,4 |

| 4 | 7,9 | 9,5 |

| 5 | 8,7 | 10,0 |

| 6 | 8,4 | 10,9 |

| 7 | 8,6 | 11,1 |

| 8 | 7,2 | 9,2 |

| 9 | 9,4 | 10,2 |

| 10 | 8,9 | 9,3 |

| 11 | 7,9 | 10,2 |

| 12 | 8,5 | 9,5 |

| \(\overline{X}\) | 8,4 | 10,2 |

| \(S\) | 0,8 | 0,9 |

¿Se puede decir que el desgaste es distinto en los diferentes tipos de cubierta? Trabajar con un nivel de confianza del 95%. Suponer que no hay diferencia en el desgaste debido a la ubicación de las cubiertas.

Solución

Como las cubiertas están instalados en una misma bicicleta, las dos muestras pueden considerarse dependientes, ya que recorren la misma distancia por idénticos trayectos y, por lo tanto, están sometidos a igual esfuerzo de desgaste. Calculando la nueva variable \(d\), tenemos:

| Bicicleta | Cubierta I | Cubierta II | \(d=I-II\) |

|---|---|---|---|

| 1 | 7,3 | 12 | -4,7 |

| 2 | 9,8 | 10,5 | -0,7 |

| 3 | 8,6 | 9,4 | -0,8 |

| 4 | 7,9 | 9,5 | -1,6 |

| 5 | 8,7 | 10 | -1,3 |

| 6 | 8,4 | 10,9 | -2,5 |

| 7 | 8,6 | 11,1 | -2,5 |

| 8 | 7,2 | 9,2 | -2 |

| 9 | 9,4 | 10,2 | -0,8 |

| 10 | 8,9 | 9,3 | -0,4 |

| 11 | 7,9 | 10,2 | -2,3 |

| 12 | 8,5 | 9,5 | -1 |

| Media | 8,4 | 10,2 | -1,7 |

| \(S\) | 0,8 | 0,9 | 1,2 |

Utilizando [est_m2md], podemos escribir:

\[\begin{aligned} P(t_{n-1;\alpha/2}\leq t_{n-1} \leq t_{n-1;1-\alpha/2})\!=\; & 1-\alpha \nonumber \\ P\bigg(t_{n-1;\alpha/2}\leq \frac{\overline{d}-\delta}{S_{d}/\sqrt{n}}\leq t_{n-1;1-\alpha/2}\bigg)\!=\; & 1-\alpha \nonumber \\ P\bigg(-\overline{d} + t_{n-1;\alpha/2} \frac{S_{d}}{\sqrt{n}} \leq -\delta\leq-\overline{d} + t_{n-1;1-\alpha/2} \frac{S_{d}}{\sqrt{n}}\bigg)\!=\; & 1-\alpha \nonumber \end{aligned}\] \[{ P\bigg(\overline{d} - t_{n-1;1-\alpha/2} \frac{S_{d}}{\sqrt{n}} \leq \delta \leq \overline{d} - t_{n-1;\alpha/2} \frac{S_{d}}{\sqrt{n}}\bigg)=1-\alpha}\]

Procediendo de igual forma que en los ejercicios anteriores, calculamos el intervalo de confianza teniendo en cuenta que \(t_{11;0.975}=2.20\), entonces:

\[\begin{aligned} \overline{d} - t_{n-1;1-\alpha/2} \frac{s_{d}}{\sqrt{n}} \leq & \delta & \leq \overline{d} - t_{n-1;\alpha/2} \frac{s_{d}}{\sqrt{n}} \nonumber \\ -1.7-2.20 \frac{1.2}{\sqrt{12}} \leq & \delta & \leq -1.7 - (-2.20) \frac{1.2}{\sqrt{12}} \nonumber \\ -2.46 \leq & \delta & \leq -0.93 \end{aligned}\]

Dado que hemos definido \(d=I-II\), la conclusión es que la cubierta I tiene un menor desgaste que la cubierta II, ya que el intervalo de confianza no incluye al cero porque sus límites son valores negativos (-2,46mm y -0,93mm). Si hubiésemos planteado \(d=II-I\), la conclusión sería que la cubierta II tiene mayor desgaste que la cubierta I.

Intervalos para la Proporción Poblacional

Sea una población dicotómica (Bernoulli), con \(N\) elementos, de los cuales \(k\) tienen una determinada propiedad. Entonces podemos definir al parámetro proporción poblacional \(\pi=k/N\), el cual es desconocido y se pretende estimar a partir de una muestra de tamaño \(n\). El estimador \(P=X/n\), donde \(X\) es el número de elementos con la propiedad deseada (éxitos) en la muestra, se denomina proporción muestral.

Teniendo en cuenta que \(X\) se distribuye como una distribución binomial (porque expresa la cantidad de éxitos en pruebas repetidas), con esperanza \(n\pi\) y varianza \(n\pi(1-\pi)\), si el tamaño de la muestra es lo suficiente grande entonces, por el TCL podemos escribir que:

\[\begin{aligned} \label{estadistico_p} \frac{P-\pi}{\sqrt{\pi(1-\pi)/n}}\sim N(0,1) \end{aligned}\]

Por el Teorema de De Moivre - Laplace, que plantea lo siguiente:

Si tenemos que \(X\) es una variable aleatoria binomial de parámetros \(n\) y \(p\), \(X \sim B(n,p)\), entonces “\(X\)” se puede aproximar a una distribución normal de media \(\mu=n\cdot p\) y desviación típica \(\sigma=\sqrt{n\cdot p \cdot (1-p)}\) si y sólo si se cumplen las siguientes condiciones:

\(n\geq 30\)

\(n\cdot p\geq 5\) y \(n\cdot (1-p)\geq 5\)

entonces, la variable binomial \(X \sim B(n,p)\) se aproxima a la variable normal \(X \sim N(n\cdot p,\sqrt{n\cdot p \cdot (1-p)})\)

De modo que, cuando se cumplen las condiciones de \(n\geq 30\), \(np\geq 5\) y \(n(1-p)\geq 5\), la aproximación anterior es adecuada y se emplea para construir el intervalo de confianza. Veamos a continuación el intervalo de confianza según se trate de una proporción poblacional o de la diferencia de proporciones de dos poblaciones.

Intervalos para la Proporción de una Población

Problema Resuelto 2.6. El Departamento de Control de Calidad de una empresa quiere estimar el verdadero valor de la proporción de productos defectuosos, para saber si necesita realizar ajustes en la línea de producción, o no. En caso de superar el 7%, debería realizar ajustes. Con este fin toma una muestra aleatoria de 80 productos encontrando que 15 de ellos tienen algún defecto. ¿Debe el departamento de control de calidad realizar algún ajuste? Utilizar un nivel de confianza del 90%.

Solución

Estamos ante un planteo con una muestra considerada grande y, por el TCL, el estadístico para la proporción es:

\[\begin{aligned} \frac{P-\pi}{\sqrt{\pi(1-\pi)/n}}\sim N(0,1) \end{aligned}\]

Para poder hacer uso de este estadístico se deben cumplir las condiciones \(nP>5\) y \(n(1-P)>5\), en este caso:

\[\begin{aligned} n\cdot p=80 \cdot \frac{15}{80}=15&>&5 \nonumber \\ n(1-p)=80 \cdot (1-\frac{15}{80})=65&>&5 \end{aligned}\]

Ahora podemos operar de forma similar a los problemas anteriores, es decir:

\[\begin{aligned} P(Z_{\alpha/2}\leq Z \leq Z_{1-\alpha/2})\!=\; & 1-\alpha \nonumber \\ P\bigg(Z_{\alpha/2}\leq \frac{P-\pi}{\sqrt{\pi(1-\pi)/n}}\leq Z_{1-\alpha/2}\bigg)\!=\; & 1-\alpha \end{aligned}\]

Despejando de la ecuación anterior surge que:

\[\begin{aligned} P\bigg(Z_{\alpha/2} \sqrt{\pi(1-\pi)/n} \leq (P-\pi) \leq Z_{1-\alpha/2} \sqrt{\pi(1-\pi)/n}\bigg)\!=\; & 1-\alpha \nonumber \\ P\bigg( -P+Z_{\alpha/2} \sqrt{\pi(1-\pi)/n} \leq -\pi \leq - P+Z_{1-\alpha/2} \sqrt{\pi(1-\pi)/n}\bigg)\!=\; & 1-\alpha \nonumber \\ P\bigg(P-Z_{1-\alpha/2} \sqrt{\pi(1-\pi)/n} \leq \pi \leq P-Z_{\alpha/2} \sqrt{\pi(1-\pi)/n}\bigg)\!=\; & 1-\alpha \nonumber \\ \end{aligned}\]

Como vemos, \(\pi\) aún sigue contenido en los extremos de la desigualdad. Para superar esta situación deberíamos plantear una ecuación de segundo grado. Sin embargo, si reemplazamos \(\pi\) por \(P\) en dichos extremos, se obtiene una aproximación muy razonable a los resultados que buscamos, por lo que planteamos:

\[{ P\bigg( P-Z_{1-\alpha/2} \sqrt{P(1-P)/n} \leq \pi \leq P-Z_{\alpha/2} \sqrt{P(1-P)/n}\bigg)=1-\alpha}\]

Sabiendo que \(P\) se define como la cantidad de éxitos sobre el total de casos de la muestra, entonces \(p=\frac{15}{80}=0.19\) tenemos:

\[\begin{aligned} p-Z_{1-\alpha/2} \sqrt{p(1-p)/n} \leq &\pi& \leq p-Z_{\alpha/2} \sqrt{p(1-p)/n} \nonumber \\ 0.19-1.64 \sqrt{0.19(1-0.19)/80} \leq & \pi & \leq 0.19-(-1.64) \sqrt{0.19(1-0.19)/80} \nonumber \\ 0.12\leq & \pi & \leq 0.26 \end{aligned}\]

Por lo tanto, con un nivel de confianza del 90%, el intervalo \([0.12; 0.26]\) contendrá el verdadero valor del parámetro poblacional \(\pi\). Esto significa que, el Departamento de Control de Calidad debe realizar algún ajuste porque el intervalo de estimación no contiene el valor \(0.07\) de defectuosos, lo cual indica que el porcentaje de defectuosos excede ese valor, ya que el intervalo se encuentra a su derecha.

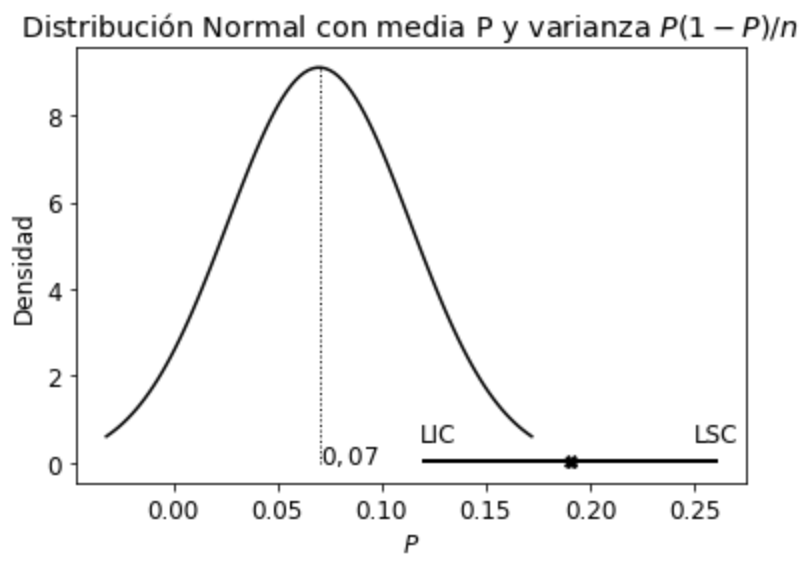

Gráficamente es:

donde la distribución centrada en \(0.07\) corresponde a la distribución esperada por el Departamento de Control de Calidad (que no necesariamente es la verdadera distribución poblacional). Como el intervalo de confianza no incluye la media de la distribución esperada por dicho departamento, entonces se deben hacer los ajustes necesarios para que la producción de defectuosos disminuya y así corregir el problema. Por cierto que, podría haber existido un problema de muestreo, o bien muy “mala suerte” al seleccionar una muestra que no contiene el parámetro poblacional. Suponiendo que no existieron problemas de muestreo, y como es poco probable (10%) que hayamos seleccionado una “mala” muestra, entonces concluimos que se deben realizar los ajustes necesarios en la línea de producción.

Una consideración adicional, es que los límites del intervalo de confianza, en el caso de \(\pi\), nunca deberán estar fuera del rango \([0,1]\), dado que estamos trabajando con proporciones, las cuales están definidas siempre entre 0 y 1.

Intervalos para la Diferencia de dos Proporciones Poblacionales

Sean dos poblaciones con una misma variable dicotómica cada una, de las que extraemos sendas muestras de tamaño grande, \(n_{1}\) y \(n_{2}\), entonces podemos escribir:

\[\begin{aligned} \frac{P_{1}-\pi_{1}}{\sqrt{\pi_{1}(1-\pi_{1})/n_{1}}}\sim N(0,1) \nonumber \\ \frac{P_{2}-\pi_{2}}{\sqrt{\pi_{2}(1-\pi_{2})/n_{2}}}\sim N(0,1) \end{aligned}\] por lo tanto, \(P_{1}\) y \(P_{2}\) se distribuyen:

\[\begin{aligned} P_{1}\sim N(\pi_{1},\pi_{1}(1-\pi_{1})/n_{1}) \nonumber \\ P_{2}\sim N(\pi_{2},\pi_{2}(1-\pi_{2})/n_{2}) \end{aligned}\]

Restando ambas variables aleatorias, teniendo en cuenta que si las variables \(P_{1}\) y \(P_{2}\) son independientes, la varianza es \(V(P_{1}-P_{2})=V(P_{1})+V(p_{2})\), entonces podemos escribir:

\[\begin{aligned} (P_{1}-P_{2})\sim N((\pi_{1}-\pi_{2}),\pi_{1}(1-\pi_{1})/n_{1}+\pi_{2}(1-\pi_{2})/n_{2}) \end{aligned}\] que es el estadístico para la diferencia de dos proporciones de variables independientes.

Estandarizando tenemos:

\[\begin{aligned} \label{estadistico_p2mi} \frac{(P_{1}-P_{2})-(\pi_{1}-\pi_{2})}{\sqrt{\pi_{1}(1-\pi_{1})/n_{1}+\pi_{2}(1-\pi_{2})/n_{2}}}\sim N(0,1) \end{aligned}\] que se utiliza para armar el intervalo de confianza de dos proporciones.

Problema Resuelto 2.7. En una fábrica de componentes de computadora donde hay instaladas dos líneas de producción, se tomaron muestras aleatorias de \(n_{1}=200\) componentes de la primera línea, y se encontraron 17 unidades defectuosas; y de \(n_{2}=150\) de la segunda línea de producción en la que se hallaron 10 componentes defectuosos. Si se compara la proporción de defectuosos de ambas líneas, ¿qué conclusión puede obtener a un nivel de confianza del 95%?

Solución

Si se cumplen las condiciones \(nP>5\) y \(n(1-P)>5\) para cada una de las muestras, entonces se puede usar el estadístico [estadistico_p2mi] para estimar un intervalo de confianza de la diferencia de proporciones.

\[\begin{aligned} n_{1}p_{1}=200 \cdot \frac{17}{200}=17&>&5 \nonumber \\ n_{1}(1-_{1})=200 \cdot (1-\frac{17}{200})=183&>&5 \nonumber \\ n_{2}p_{2}=150 \cdot \frac{10}{150}=10&>&5 \nonumber \\ n_{2}(1-p_{2})=150 \cdot (1-\frac{10}{150})=140&>&5 \end{aligned}\]

Luego,

\[\begin{aligned} P(Z_{\alpha/2}\leq Z \leq Z_{1-\alpha/2})\!=\; & 1-\alpha \nonumber \\ P\bigg(Z_{\alpha/2}\leq \frac{(P_{1}-P_{2})-(\pi_{1}-\pi_{2})}{\sqrt{\pi_{1}(1-\pi_{1})/n_{1}+\pi_{2}(1-\pi_{2})/n_{2}}} \leq Z_{1-\alpha/2}\bigg)\!=\; & 1-\alpha \end{aligned}\]

Despejando \((\pi_{1}-\pi_{2})\) de la desigualdad y realizando la aproximación de reemplazar \(\pi\) por \(P\), tenemos:

\[\begin{aligned} P\bigg(Z_{\alpha/2}\leq \frac{(P_{1}-P_{2})-(\pi_{1}-\pi_{2})}{\sqrt{\frac{P_{1}(1-P_{1})}{n_{1}}+\frac{P_{2}(1-P_{2})}{n_{2}}}} \leq Z_{1-\alpha/2}\bigg)=1-\alpha \nonumber \\ P\bigg(Z_{\alpha/2} \sqrt{\widehat{\sigma}_{(P_{1}-P_{2})}} \leq (P_{1}-P_{2})-(\pi_{1}-\pi_{2}) \leq Z_{1-\alpha/2} \sqrt{\widehat{\sigma}_{(P_{1}-P_{2})}} \bigg)=1-\alpha \nonumber \\ P\bigg(-(P_{1}-P_{2})+Z_{\alpha/2} \sqrt{\widehat{\sigma}_{(P_{1}-P_{2})}} \leq -(\pi_{1}-\pi_{2}) \leq -(P_{1}-P_{2})+Z_{1-\alpha/2} \sqrt{\widehat{\sigma}_{(P_{1}-P_{2})}} \bigg)=1-\alpha \nonumber \end{aligned}\] \[{ P\bigg((P_{1}-P_{2})-Z_{1-\alpha/2} \sqrt{\widehat{\sigma}_{(P_{1}-P_{2})}} \leq (\pi_{1}-\pi_{2}) \leq (P_{1}-P_{2})-Z_{\alpha/2} \sqrt{\widehat{\sigma}_{(P_{1}-P_{2})}} \bigg)=1-\alpha}\] donde \(\widehat{\sigma}_{(P_{1}-P_{2})}=\frac{P_{1}(1-P_{1})}{n_{1}}+\frac{P_{2}(1-P_{2})}{n_{2}}\).

La estimación por intervalo es:

\[\begin{aligned} (p_{1}-p_{2})-Z_{1-\alpha/2} \sqrt{\widehat{\sigma}_{(p_{1}-p_{2})}} \leq &(\pi_{1}-\pi_{2})& \leq (p_{1}-p_{2})-Z_{\alpha/2} \sqrt{\widehat{\sigma}_{(p_{1}-p_{2})}} \nonumber \\ (0.085-0.067)-1.96 \sqrt{0.000804} \leq & (\pi_{1}-\pi_{2}) & \leq (0.085-0.067)-(-1.96) \sqrt{0.000804} \nonumber \\ -0.0372 \leq & (\pi_{1}-\pi_{2}) & \leq 0.0739 \nonumber \\ \end{aligned}\] donde \(\widehat{\sigma}_{p_{1}-p_{2}}=0.000804\).

Dado que el cero está incluido en el intervalo de confianza, la conclusión es que no existe diferencia significativa de la proporción de defectuosos entre las líneas de producción, a un nivel de confianza de 95%.

Intervalos para la Varianza Poblacional

Nuevamente, aquí tendremos en cuenta dos situaciones, según estemos en presencia de una o de dos poblaciones.

Intervalos para la Varianza de una Población

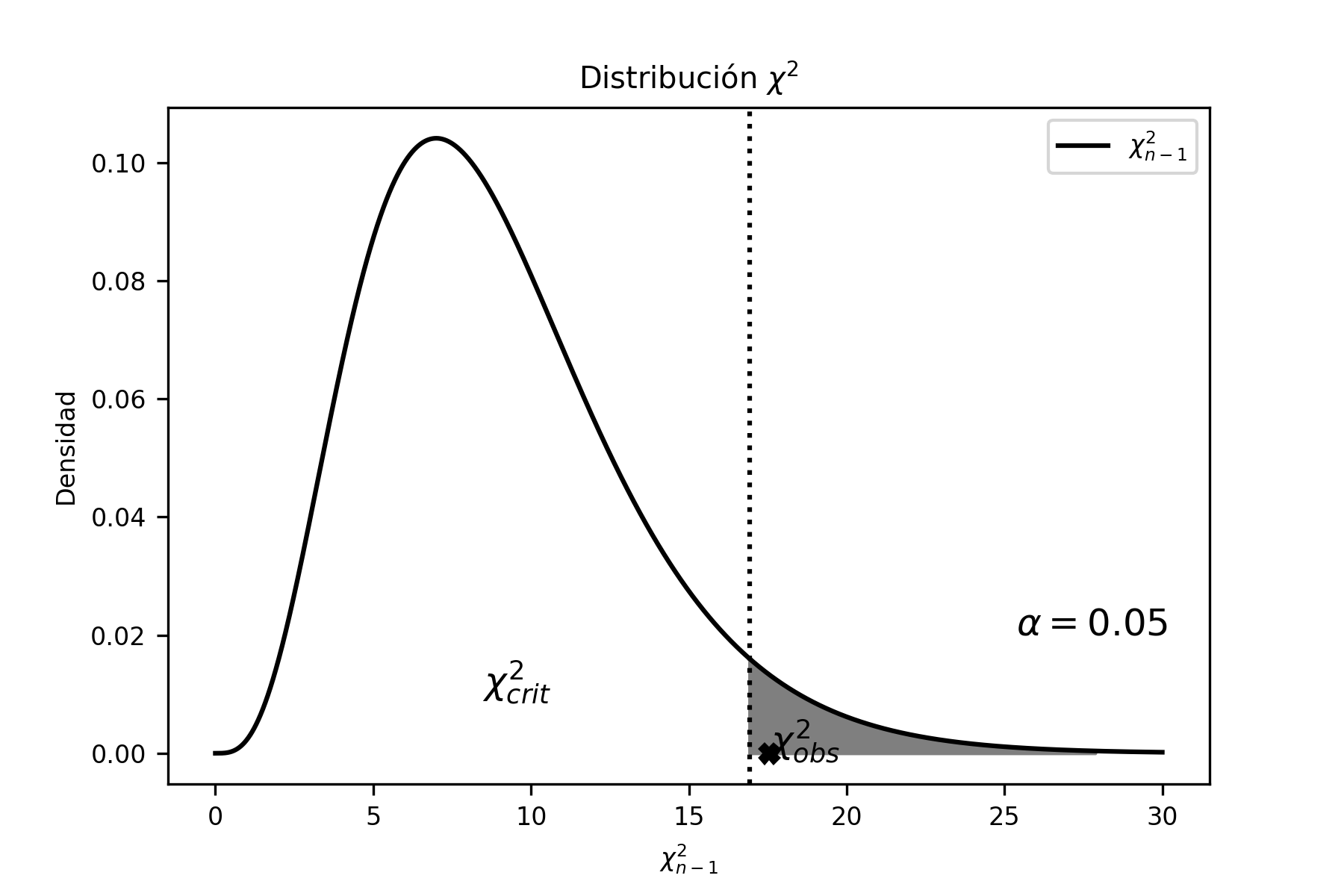

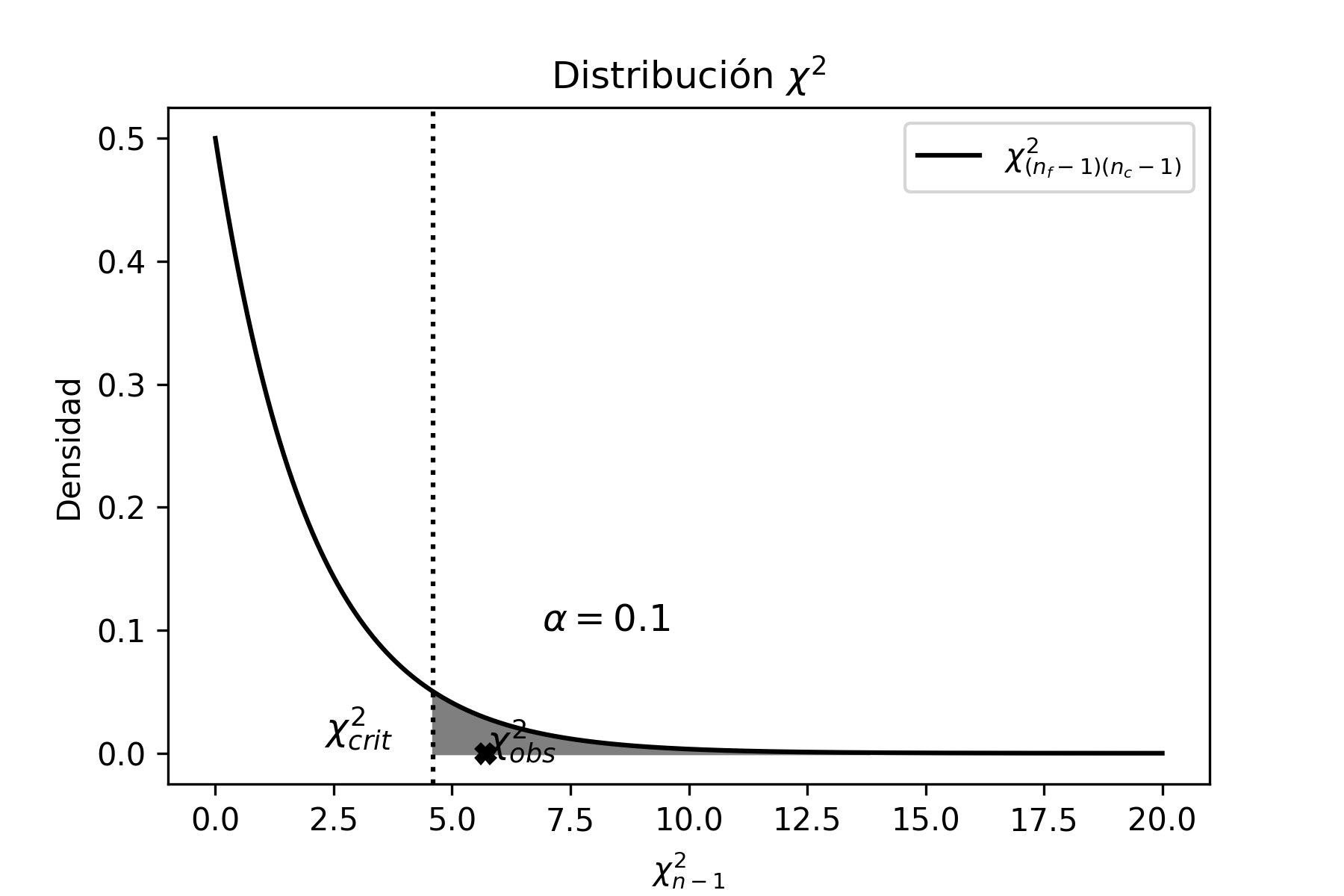

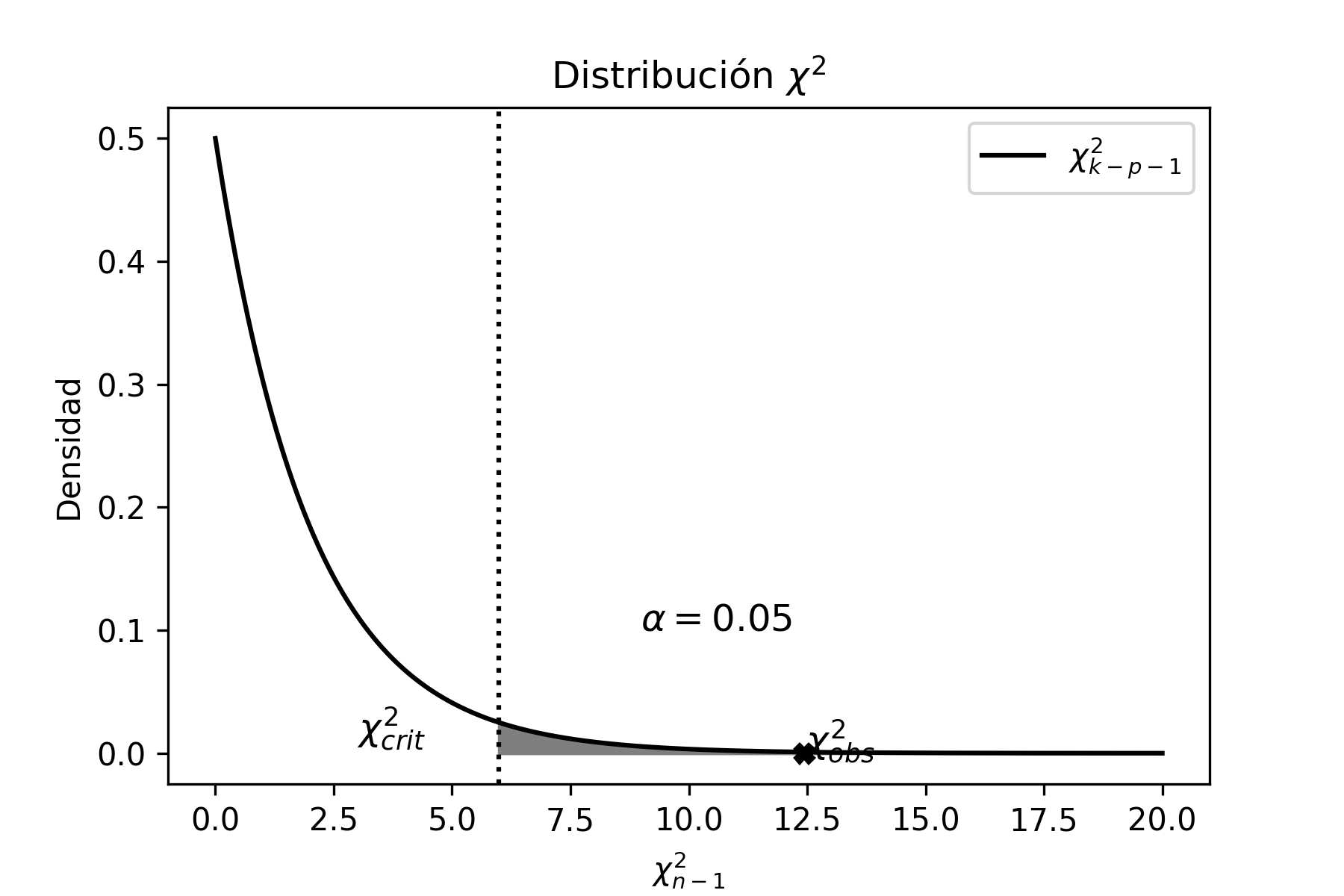

Cuando se trata de estimar intervalos de confianza para la varianza de una población, extraemos una muestra y hacemos uso del estadístico \(\chi^{2}\) que viene dado en [estadistico_chi], bajo el supuesto de poblaciones normales. Es decir:

\[\begin{aligned} \frac{(n-1)S^{2}}{\sigma^{2}} \sim \chi^{2}_{n-1} \end{aligned}\]

Problema Resuelto 2.8. Un agente de bolsa debe asesorar a un nuevo inversor con relación al precio de las acciones de una empresa energética de España (Iberdrola), no sólo en su promedio sino también en su variabilidad. Para ello computó los valores diarios de cotizaciones (en euros) durante los primeros 24 días del mes anterior y obtuvo los resultados que aparecen en la tabla. ¿Qué información podrá dar el agente de bolsa a un nivel de confianza del 95%? Suponer que la variable se distribuye normalmente en la población.

| Día | Cotización (€) | Día | Cotización (€) |

|---|---|---|---|

| 26-may-2020 | 9.252 | 11-jun-2020 | 9.682 |

| 27-may-2020 | 9.604 | 12-jun-2020 | 9.750 |

| 28-may-2020 | 9.618 | 15-jun-2020 | 9.712 |

| 29-may-2020 | 9.688 | 16-jun-2020 | 10.010 |

| 01-jun-2020 | 9.700 | 17-jun-2020 | 10.015 |

| 02-jun-2020 | 9.932 | 18-jun-2020 | 9.962 |

| 03-jun-2020 | 10.115 | 19-jun-2020 | 10.190 |

| 04-jun-2020 | 9.958 | 22-jun-2020 | 10.130 |

| 05-jun-2020 | 10.030 | 23-jun-2020 | 10.285 |

| 08-jun-2020 | 10.130 | 24-jun-2020 | 9.998 |

| 09-jun-2020 | 10.150 | 25-jun-2020 | 10.110 |

| 10-jun-2020 | 9.986 | 26-jun-2020 | 10.040 |

| \(\overline{X}=9.919\) | |||

| \(S^{2}=0.059\) | |||

Solución

El agente puede proporcionar información, sobre la media y la varianza poblacional. Empecemos analizando la media poblacional. Dado que descocemos la varianza poblacional y tenemos un tamaño de muestra inferior a 30, el intervalo de confianza que se debe calcular para la media poblacional es:

\[\begin{aligned} P\bigg(\overline{X} - t_{n-1;1-\alpha/2} \frac{S}{\sqrt{n}} \leq \mu \leq \overline{X} - t_{n-1;\alpha/2} \frac{S}{\sqrt{n}}\bigg)\!=\; & 1-\alpha \end{aligned}\]

Con los datos de la muestra se obtiene que \(\overline{X}=9.92\) y que \(S=0.242\), entonces el intervalo para la media poblacional con un nivel de confianza del 95% es:

\[\begin{aligned} \overline{x} - t_{n-1;1-\alpha/2} \frac{s}{\sqrt{n}} \leq &\mu &\leq \overline{x} - t_{n-1;\alpha/2} \frac{s}{\sqrt{n}} \nonumber \\ 9.92- 2.069 \frac{0.242}{\sqrt{24}} \leq &\mu& \leq 9.92 - 2.069 \frac{0.242}{\sqrt{24}} \nonumber \\ 9.816 \leq &\mu& \leq 10.021 \end{aligned}\]

Cuando tenemos una muestra, y queremos estimar un intervalo de confianza de la varianza, debemos partir del estadístico [estadistico_chi] y plantear:

\[\begin{aligned} P(\chi^{2}_{n-1;\alpha/2}\leq \chi^{2}_{n-1} \leq \chi^{2}_{n-1;1-\alpha/2})\!=\; & 1-\alpha \nonumber \\ P\bigg(\chi^{2}_{n-1;\alpha/2}\leq \frac{(n-1)S^{2}}{\sigma^{2}} \leq \chi^{2}_{n-1;1-\alpha/2}\bigg)\!=\; & 1-\alpha \end{aligned}\]

Despejando \(\sigma^{2}\) de la desigualdad:

\[\begin{aligned} P\bigg(\frac{\chi^{2}_{n-1;\alpha/2}}{(n-1)S^{2}}\leq \frac{1}{\sigma^{2}} \leq \frac{\chi^{2}_{n-1;1-\alpha/2}}{(n-1)S^{2}}\bigg)\!=\; & 1-\alpha \nonumber \end{aligned}\] \[{ P\bigg(\frac{(n-1)S^{2}}{\chi^{2}_{n-1;1-\alpha/2}}\leq \sigma^{2} \leq \frac{(n-1)S^{2}}{\chi^{2}_{n-1;\alpha/2}}\bigg)=1-\alpha}\]

Reemplazando la varianza muestral, y teniendo en cuenta que los grados de libertad con los que debemos trabajar son \(n-1=23\), donde \(n\) es el tamaño de la muestra, obtenemos:

\[\begin{aligned} \frac{(n-1)s^{2}}{\chi^{2}_{n-1;1-\alpha/2}}\leq &\sigma^{2} &\leq \frac{(n-1)s^{2}}{\chi^{2}_{n-1;\alpha/2}} \nonumber \\ \frac{(24-1)0.059}{\chi^{2}_{24-1;0.975}}\leq & \sigma^{2} & \leq \frac{(24-1)0.059}{\chi^{2}_{24-1;0.025}} \nonumber \\ \frac{(24-1)0.059}{38.076}\leq & \sigma^{2} & \leq \frac{(24-1)0.059}{11.689} \nonumber \\ 0.035 \leq & \sigma^{2} & \leq 0.115 \end{aligned}\]

Por lo tanto, el agente de bolsa dirá a su cliente que, el precio promedio puntual de la acción es 9,919 € y que, con un 95% de nivel de confianza se encuentra entre 9,816€ y 10,021€. La varianza, por su parte, oscila, con un 95% de confianza, entre 0,035 y 0,115.

La resolución de la segunda parte de este problema en Python es (se deja a cargo del lector la resolución de la primera parte):

# Librerias

import numpy as np

from scipy import stats

from scipy.stats import chi2

from statsmodels.stats import weightstats as stests

import statistics

from statistics import stdev

# Nivel de confianza

nivel_conf=0.95

# Datos muestrales

data=[9.252,9.604,9.618,9.688,9.7,9.932,10.115,9.958,10.03,

10.13,10.15,9.986,9.682,9.75,9.712,10.01,10.015,9.962,

10.19,10.13,10.285,9.998,10.11,10.04]

def ic(data,nivel_conf):

n = len(data)

chi_1 = chi2.ppf(nivel_conf+(1-nivel_conf)/2,n-1)

chi_2 = chi2.ppf(1-(nivel_conf+(1-nivel_conf)/2),n-1)

data_mean = np.mean(data)

data_sd = stdev( data, data_mean )

var=data_sd**2

lim_inf=(n-1)*var/chi_1

lim_sup=(n-1)*var/chi_2

return lim_inf,lim_sup,data_mean,var,n

lim_inf,lim_sup,data_mean,var,n = ic(data,nivel_conf)

print("Media Muestral =",data_mean)

print("Varianza Muestral =",var)

print("n Muestral")

print("Intervalo de confianza: ","[",lim_inf,";",lim_sup,"]")

Media Muestral = 9.918624999999999

Varianza Muestral = 0.05856685326086955

n Muestral

Intervalo de confianza: [ 0.03537794968269136 ; 0.11524418370529599 ]Intervalos para la Comparación de Varianzas de dos Poblaciones

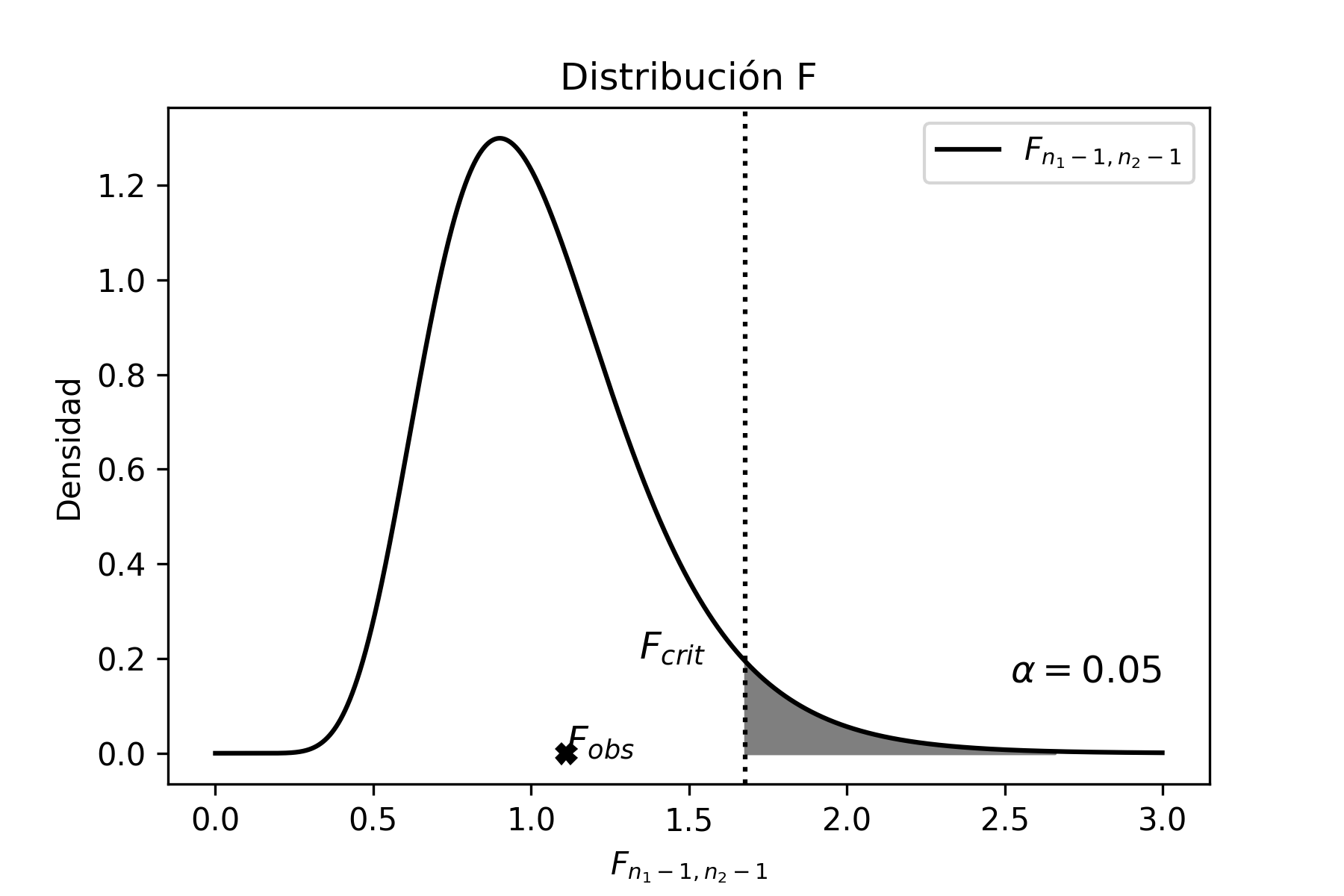

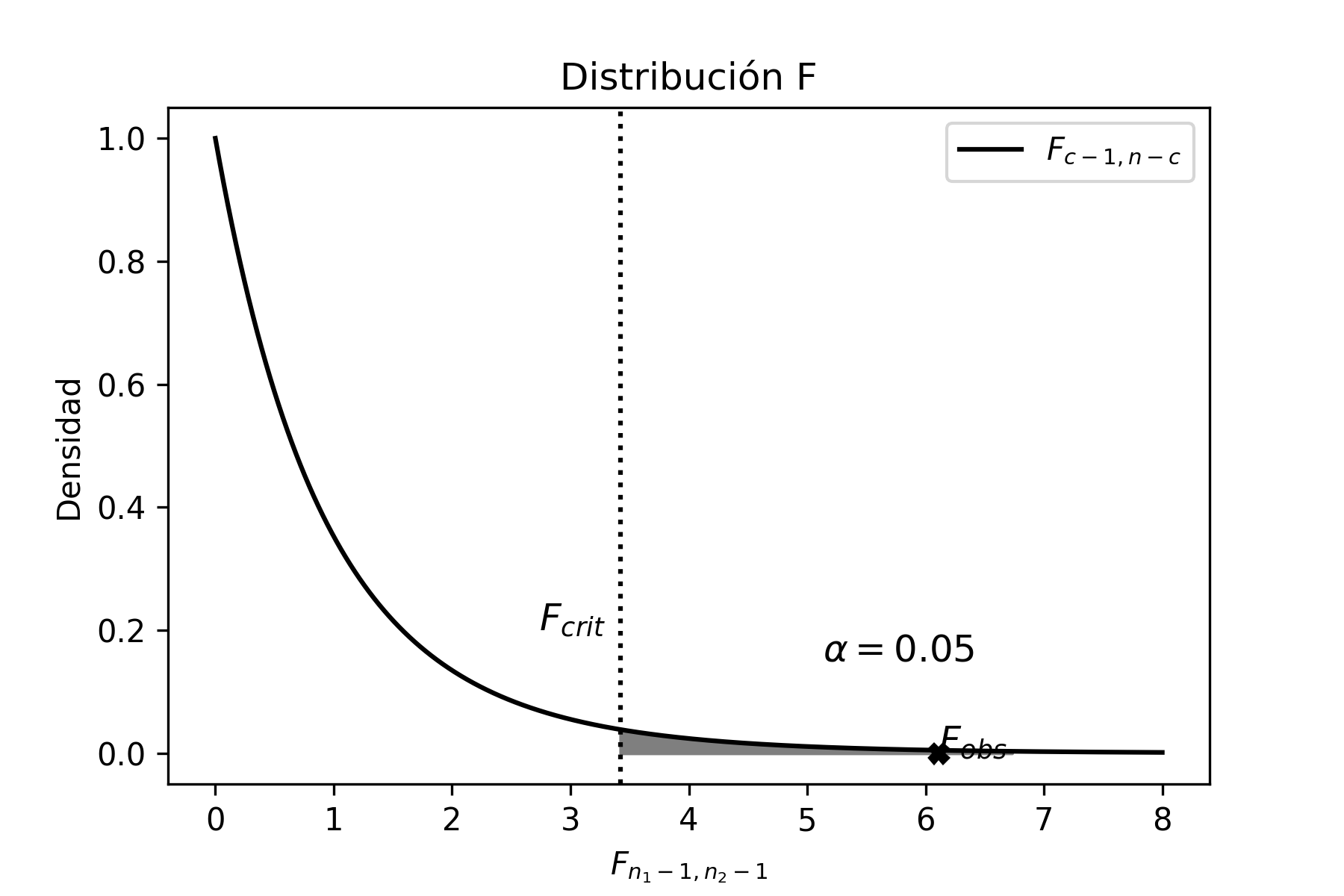

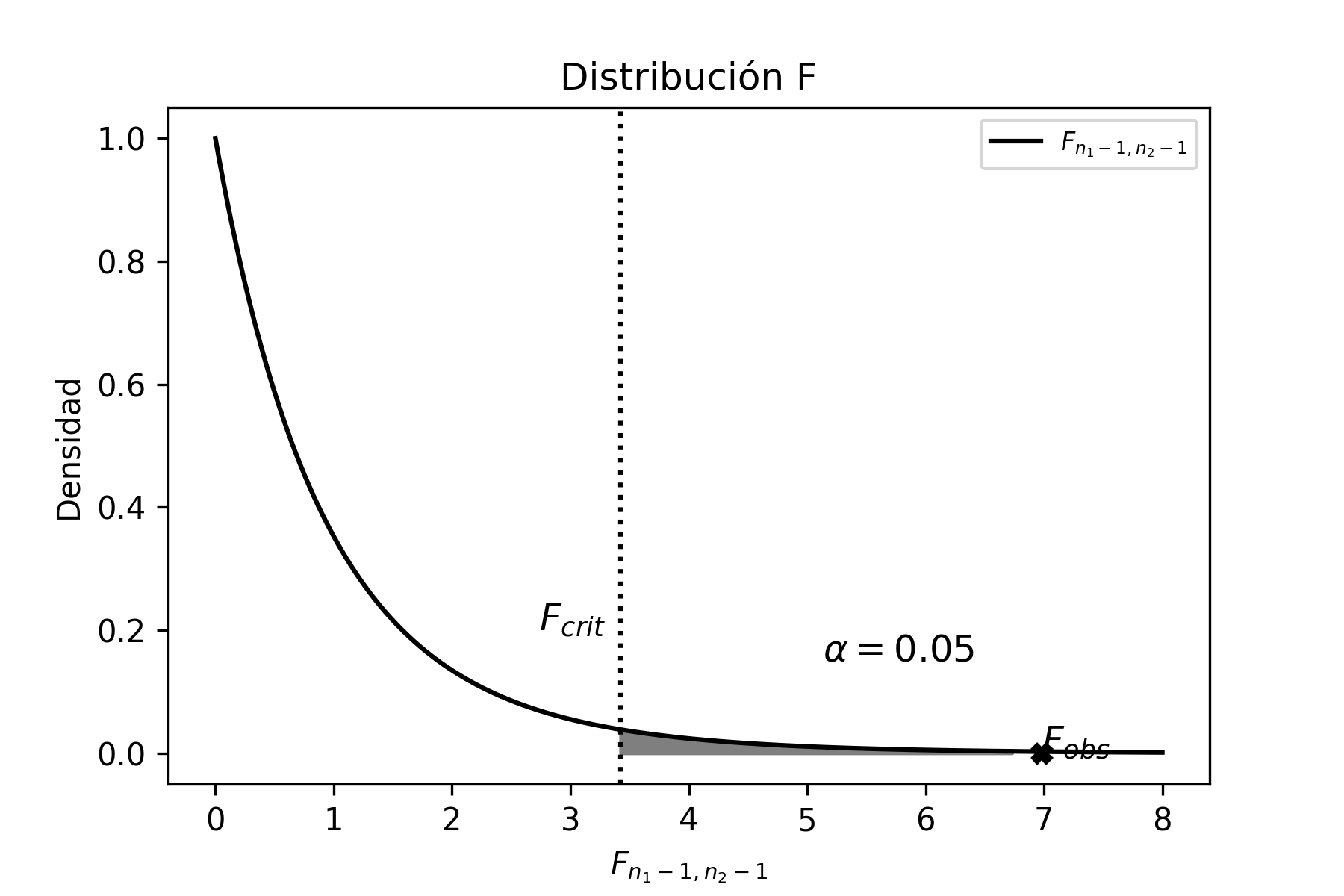

En el caso que se quiera estimar intervalos para comparar varianzas de dos poblaciones, se hace uso del estadístico \(F\) ([estadistico_f1]):

\[\begin{aligned} \frac{S_{1}^{2}}{S_{2}^{2}}\frac{\sigma_{2}^{2}}{\sigma_{1}^{2}} \sim F_{n_{1}-1,n_{2}-1} \nonumber \end{aligned}\]

Problema Resuelto 2.9. La resistencia del hormigón es un factor fundamental en la construcción. Una empresa dedicada a la fabricación de hormigón está investigando acerca de un nuevo producto el cual, aseguran los ingenieros, tendría una mayor resistencia que el actual producto de mercado, y con una menor variabilidad. Para verificar el supuesto de los ingenieros se tomaron dos muestras aleatorias, una de cada tipo de hormigón, y se las sometió a pruebas de resistencia, con los siguientes resultados:

| Hormigón | Actual | 22,6 | 24,1 | 24,9 | 22,8 | 22,4 | ||

| Nuevo | 31,0 | 29,3 | 30,8 | 29,1 | 30,3 | 30,5 | 30,3 |

Suponiendo que ambas poblaciones se distribuyen normalmente, determinar si existe diferencia significativa, a un nivel de confianza del 99%, en la variabilidad de la resistencia de ambos tipos de hormigón.

Solución

Dado que en esta ocasión estamos trabajando con dos muestras y suponemos que ambas poblaciones se distribuyen normales, entonces vamos a partir del estadístico \(F\) ([estadistico_f1]):

\[\begin{aligned} P(F_{n_{1}-1;n_{2}-1}^{\alpha/2}\leq F_{n_{1}-1;n_{2}-1} \leq F_{n_{1}-1;n_{2}-1}^{1-\alpha/2})\!=\; & 1-\alpha \nonumber \\ P\bigg(F_{n_{1}-1;n_{2}-1}^{\alpha/2}\leq \frac{S_{1}^{2}}{S_{2}^{2}}\frac{\sigma_{2}^{2}}{\sigma_{1}^{2}} \leq F_{n_{1}-1;n_{2}-1}^{1-\alpha/2}\bigg)\!=\; & 1-\alpha \end{aligned}\]

Despejando, dentro de la desigualdad, la relación \(\frac{\sigma_{1}^{2}}{\sigma_{2}^{2}}\):

\[\begin{aligned} P\bigg(F_{n_{1}-1;n_{2}-1}^{\alpha/2} \frac{S_{2}^{2}}{S_{1}^{2}} \leq \frac{\sigma_{2}^{2}}{\sigma_{1}^{2}} \leq F_{n_{1}-1;n_{2}-1}^{1-\alpha/2}\frac{S_{2}^{2}}{S_{1}^{2}} \bigg)\!=\; & 1-\alpha \nonumber \end{aligned}\] \[{ P\bigg(\frac{1}{F_{n_{1}-1;n_{2}-1}^{1-\alpha/2}} \frac{S_{1}^{2}}{S_{2}^{2}} \leq \frac{\sigma_{1}^{2}}{\sigma_{2}^{2}} \leq \frac{1}{F_{n_{1}-1;n_{2}-1}^{\alpha/2}}\frac{S_{1}^{2}}{S_{2}^{2}} \bigg)=1-\alpha}\]

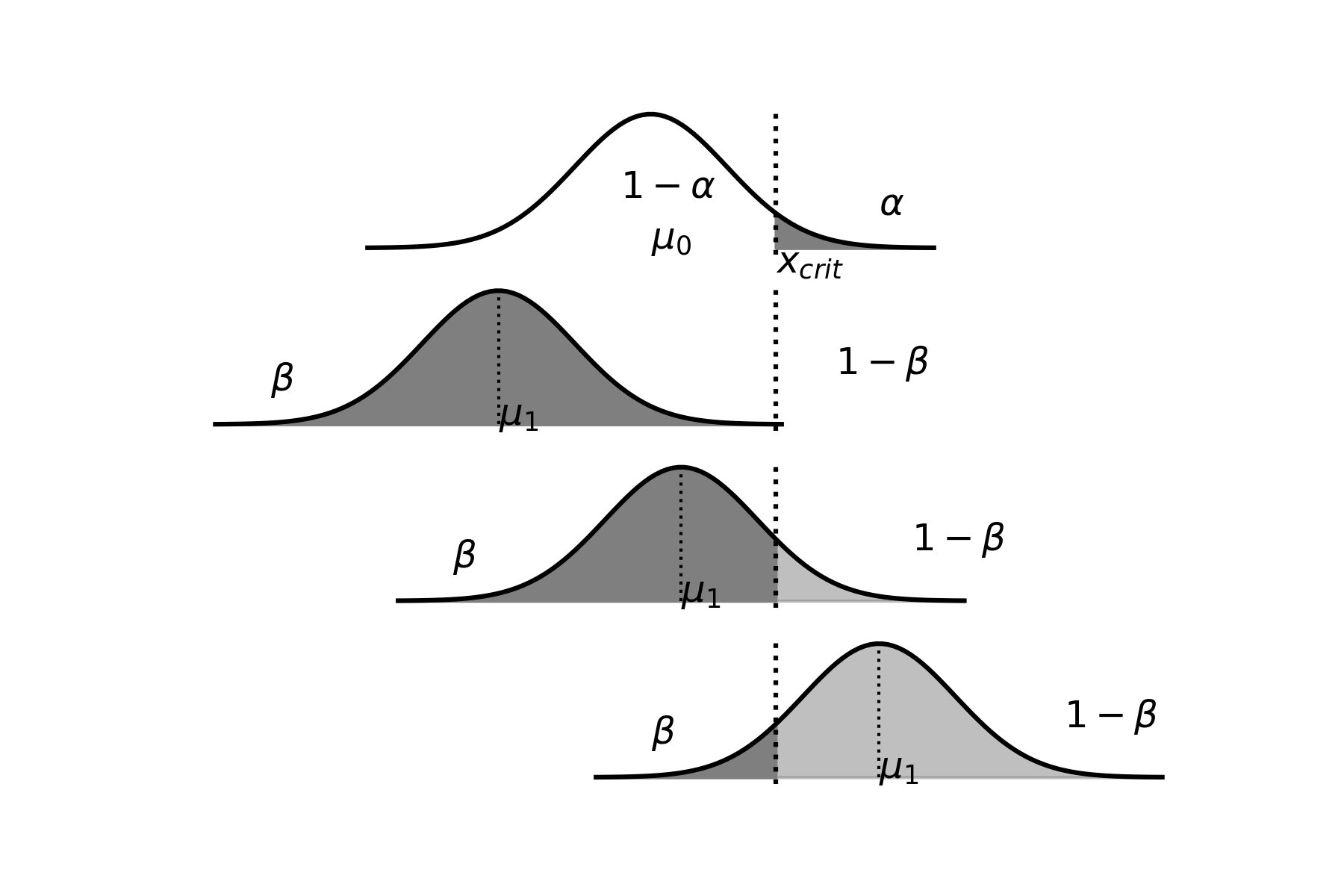

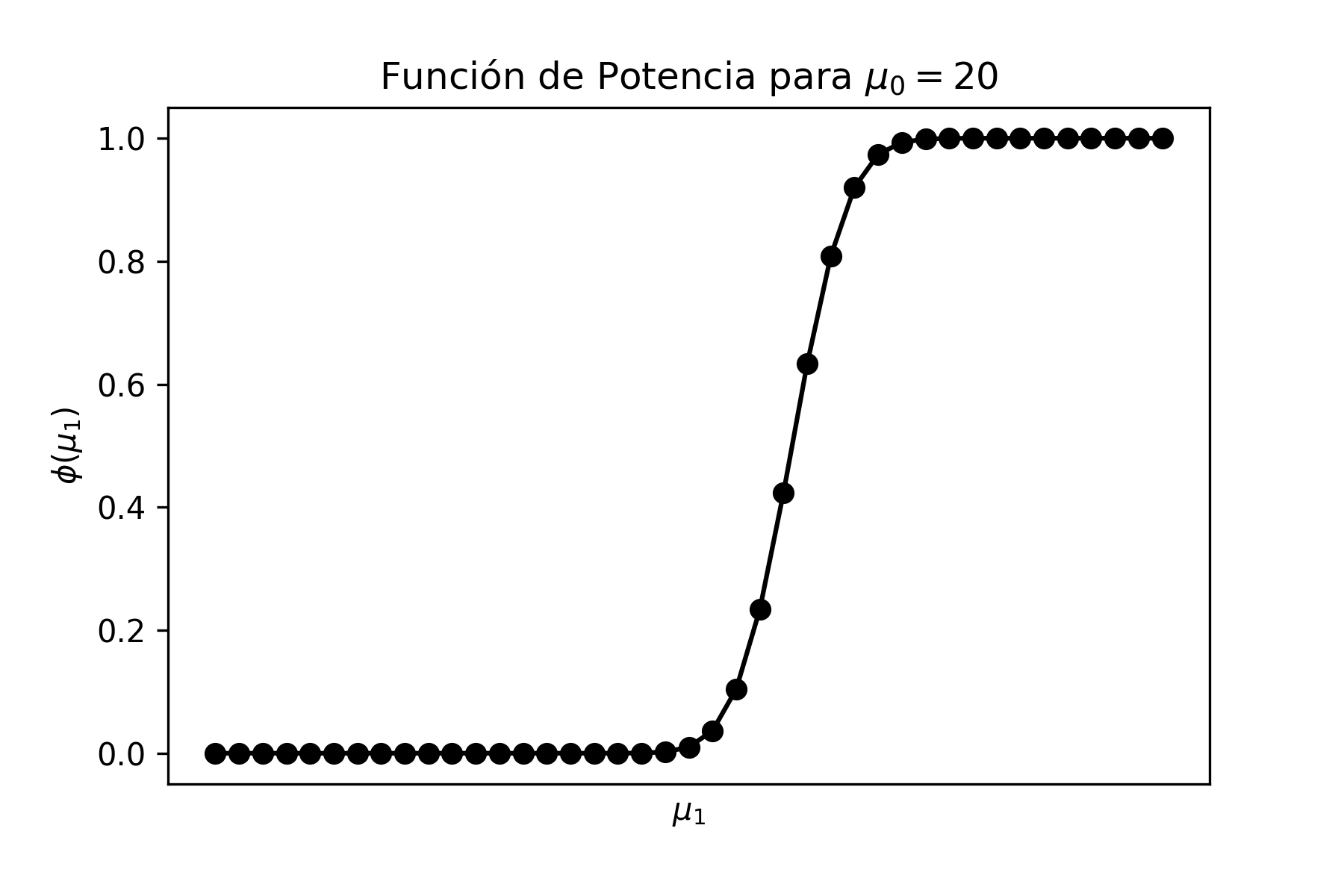

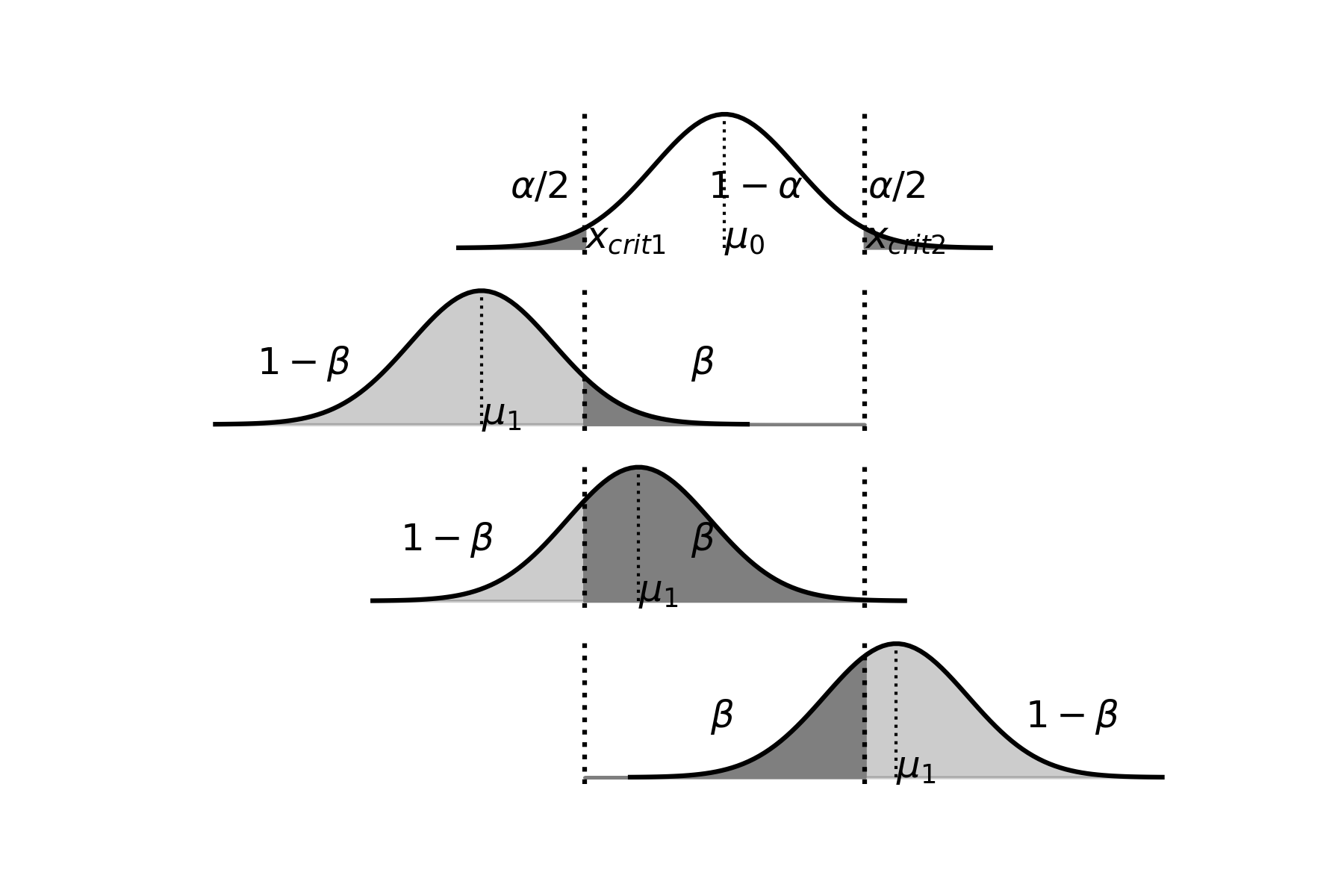

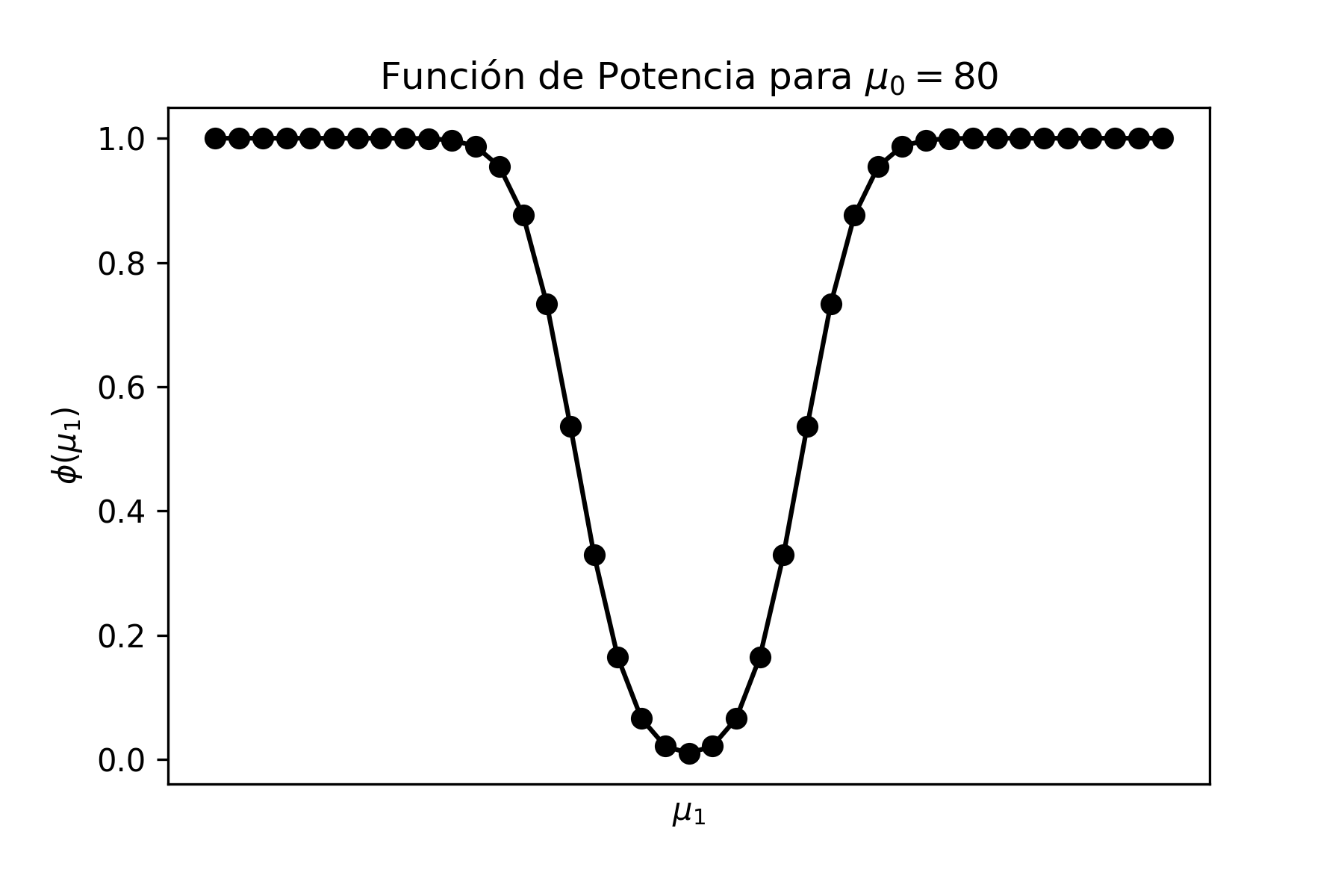

Calculando las varianzas muestrales, tenemos: \(s_{actual}^{2}=1.183\) y \(s_{nuevo}^{2}=0.521\) respectivamente. Por otra parte, dado que el tamaño de la muestra para el hormigón actual es de 5 y para el hormigón nuevo es de 7, entonces podemos escribir: